Seguir a jornada do prompt

Objetivos de aprendizagem

Após concluir esta unidade, você estará apto a:

- Explicar como o Trust Layer trata seus dados com segurança.

- Descrever como a fundamentação dinâmica melhora o contexto de um prompt.

- Descrever como as proteções do Trust Layer defendem seus dados.

Trailcast

Se você deseja escutar uma gravação de áudio deste módulo, use o reprodutor abaixo. Quando terminar de escutar essa gravação, lembre-se de voltar a cada unidade, consultar os recursos e completar as avaliações associadas.

A jornada do prompt

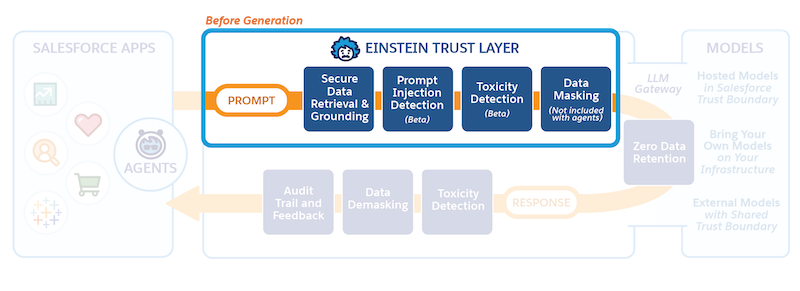

Você acabou de aprender um pouco sobre o que é o Trust Layer, e agora vamos ver como ele se encaixa no panorama geral da IA generativa no Salesforce. Nesta unidade, você aprenderá como um prompt passa pelo Einstein Trust Layer a caminho do LLM.

A defesa do prompt está disponível no Criador de prompts, na API de conexão do modelo de prompt e na ação invocável do modelo de prompt.

O poder dos prompts

No módulo do Trailhead, Noções básicas de prompt, você aprenderá que os prompts são o que alimentam os aplicativos de IA generativa. E também que instruções claras, informações contextuais e restrições ajudam a criar um ótimo prompt, o que leva a uma ótima resposta do LLM. Para tornar isso fácil e consistente para nossos clientes, criamos previamente modelos de prompt para todos os tipos de casos de uso de negócios, como e-mails de vendas ou respostas de atendimento ao cliente. Quando é feita uma solicitação ao Trust Layer em qualquer um de nossos aplicativos do Salesforce, um modelo de prompt relevante é chamado pelo Trust Layer.

Vejamos um caso de atendimento ao cliente para ilustrar a jornada do prompt. Você verá o modelo de prompt, como o modelo é preenchido com dados do cliente e recursos relevantes, e como o Einstein Trust Layer protege os dados antes da transferência para um LLM externo, que vai gerar uma resposta relevante ao prompt.

Essa é a Jéssica

A Jéssica é agente de atendimento ao cliente em uma empresa de cartões de crédito para o consumidor. A empresa dela acaba de implementar Respostas de atendimento, um recurso desenvolvido pelo Einstein que gera respostas sugeridas aos agentes de atendimento ao cliente durante as conversas de bate-papo com os clientes. A Jéssica concordou em ser uma das primeiras agentes a experimentar. Ela é conhecida por seu toque pessoal no trato com os clientes. Por isso, está um pouco apreensiva porque as respostas geradas por IA podem não ser compatíveis com o estilo dela. Mas ela está ansiosa para adicionar alguma experiência de IA generativa ao seu currículo e curiosa para ver se as Respostas de atendimento podem ajudá-la a atender mais clientes.

Jéssica começa a conversar com seu primeiro cliente do dia, que quer ajuda para fazer um upgrade do cartão de crédito. O recurso Respostas de atendimento começa a sugerir respostas diretamente no Service Console. As respostas são atualizadas cada vez que o cliente envia uma nova mensagem, para que tenham sentido naquele contexto da conversa. Elas também são personalizadas para o cliente, com base nos dados do cliente armazenados no Salesforce. Cada resposta sugerida é criada por meio de um modelo de prompt. O modelo de prompt contém instruções e espaços reservados que serão preenchidos com dados comerciais – neste caso, os dados do cliente de Jéssica e do caso de suporte, além de dados e fluxos relevantes da organização de Jéssica. O modelo de prompt está por trás do Trust Layer do Salesforce e Jéssica, como usuária final no Service Console, não consegue ver os modelos de prompt.

Vamos ver mais detalhadamente como esses dados passam pelo Trust Layer para fornecer respostas relevantes e de alta qualidade, mantendo a segurança e a proteção dos dados do cliente.

Você é um agente em {!organization.name}. Seu cliente é {!contact.name} em {!account.name} e está localizado em {!contact.address}, sendo cliente há {!customer.history}.

Gere a resposta do agente de atendimento ao cliente na conversa com um cliente abaixo. Peça detalhes sobre o problema do cliente, mas não ofereça nenhuma sugestão ou solução específica. Se não tiver certeza, diga que analisará a questão.

Conversa: {!conv_context}

Aqui estão os artigos de conhecimento que serão relevantes para sua resposta ao cliente.

Artigos relevantes: {!Retriever.knowledge_recommendations}

Fundamentação dinâmica

Respostas relevantes e de alta qualidade exigem inserção de dados relevantes e de alta qualidade. Quando o cliente de Jéssica entra na conversa, o recurso Respostas de atendimento vincula a conversa a um modelo de prompt e começa a substituir os campos de espaço reservado por contexto de página, campos de mesclagem e artigos de conhecimento relevantes com base no registro do cliente. Esse processo é chamado de fundamentação dinâmica. Em geral, quanto mais fundamentado for o prompt, mais precisa e relevante será a resposta. A fundamentação dinâmica é o que torna os modelos de prompt reutilizáveis para que possam ser escalados para toda a organização.

O processo de fundamentação dinâmica começa com recuperação segura de dados, que identifica dados relevantes sobre o cliente de Jéssica na organização dela. Mais importante ainda, a recuperação segura de dados respeita todas as permissões do Salesforce atualmente em vigor na organização dela, que limitam o acesso a determinados dados em objetos, campos e outros. Isso garante que Jéssica extrai apenas as informações que está autorizada a acessar. Os dados recuperados não contêm nenhuma informação privada ou qualquer coisa que exija permissões com necessidade de escalação.

Você é um agente na Cumulus Financial. Seu cliente é Dennis Maxfield da Northern Trail Outfitters e está localizado em 415 Mission St., San Francisco, CA, 94105, sendo cliente há 5 anos.

Gere a resposta do agente de atendimento ao cliente na conversa com um cliente abaixo. Peça detalhes sobre o problema do cliente, mas não ofereça nenhuma sugestão ou solução específica. Se não tiver certeza, diga que analisará a questão.

Conversa: “Oi, não estou conseguindo atualizar meu cartão de crédito Cumulus. Você pode ajudar? Há uma pontuação de crédito mínima exigida para alguns desses cartões?”

Aqui estão os artigos de conhecimento que serão relevantes para sua resposta ao cliente.

Artigos relevantes: {!Retriever.knowledge_recommendations}

Busca semântica

No caso de Jéssica, os dados do cliente são suficientes para personalizar a conversa. Mas não bastam para ajudar Jéssica a resolver o problema do cliente de forma rápida e eficaz. Jéssica precisa de informações de outras fontes de dados, como artigos de conhecimento e histórico de clientes, para responder a perguntas e identificar soluções. A busca semântica usa aprendizagem de máquina e métodos de pesquisa para encontrar informações relevantes em outras fontes de dados que podem ser incluídas automaticamente no prompt. Isso significa que Jéssica não precisa procurar essas fontes manualmente, o que economiza tempo e esforço.

Aqui, a busca semântica encontrou um artigo de conhecimento relevante para ajudar a resolver o caso do cartão de crédito e incluiu a parte relevante do artigo no modelo de prompt. Agora, o prompt está realmente tomando forma!

Você é um agente na Cumulus Financial. Seu cliente é Dennis Maxfield da Northern Trail Outfitters e está localizado em 415 Mission St., San Francisco, CA 94105, sendo cliente há 5 anos.

Gere a resposta do agente de atendimento ao cliente na conversa com um cliente abaixo. Peça detalhes sobre o problema do cliente, mas não ofereça nenhuma sugestão ou solução específica. Se não tiver certeza, diga que analisará a questão.

Conversa: “Oi, não estou conseguindo atualizar meu cartão de crédito Cumulus. Você pode ajudar? Há uma pontuação de crédito mínima exigida para alguns desses cartões?”

Aqui estão os artigos de conhecimento que serão relevantes para sua resposta ao cliente.

Artigos relevantes: “Lembre-se de analisar os requisitos para um cartão de crédito, garantindo que o cliente tenha fornecido todas as informações necessárias e tenha uma pontuação de crédito superior ao valor mínimo exigido para um novo cartão de crédito”

Mascaramento de dados

Embora o prompt contenha dados precisos sobre o cliente de Jéssica e o caso, ele ainda não está pronto para ir para o LLM porque contém informações como nomes e endereços de clientes. O Trust Layer adiciona mais um nível de proteção aos dados do cliente de Jéssica usando o mascaramento de dados. O mascaramento de dados envolve a tokenização de cada valor, de modo que cada valor seja substituído por um espaço reservado com base no que representa. Isso significa que o LLM pode manter o contexto da conversa de Jéssica com seu cliente e ainda gerar uma resposta relevante.

O Salesforce usa uma combinação de correspondência de padrões e técnicas avançadas de machine learning para identificar de forma inteligente detalhes do cliente, como nomes e informações de cartão de crédito, e depois mascará-los. O mascaramento de dados acontece nos bastidores; então, Jéssica não precisa fazer nada para evitar que os dados de seus clientes sejam expostos ao LLM. Na próxima unidade, você aprenderá como esses dados são adicionados novamente à resposta.

Embora o Salesforce tenha uma política de retenção zero de dados com os LLMs de terceiros, algumas empresas e casos de uso ou políticas de regulamentação podem exigir que não sejam enviados dados confidenciais ao LLM. Jessica fala com seu administrador do Salesforce para ter certeza de que o mascaramento de dados está ativado, evitando assim que os dados confidenciais de seus clientes sejam enviados ao LLM.

O mascaramento de dados para LLMs está atualmente desativado para agentes. Para recursos de IA generativa incorporados, tais como Respostas de atendimento do Einstein, o mascaramento de dados com Resumos de trabalho do Einstein está disponível, portanto, Jessica pode usar essa opção para seu caso de uso.

Você é um agente em <COMPANY_1>. Seu cliente é <NAME_1> em <COMPANY_2> e está localizado em <ADDRESS_1>, sendo cliente há 5 anos.

Gere a resposta do agente de atendimento ao cliente na conversa com um cliente abaixo. Peça detalhes sobre o problema do cliente, mas não ofereça nenhuma sugestão ou solução específica. Se não tiver certeza, diga que analisará a questão.

Conversa: “Oi, não estou conseguindo fazer o upgrade do meu <CREDIT_CARD_1>. Você pode ajudar? Há uma pontuação de crédito mínima exigida para alguns desses cartões? ”

Aqui estão os artigos de conhecimento que serão relevantes para sua resposta ao cliente.

Artigos relevantes: “Lembre-se de analisar os requisitos para um cartão de crédito, garantindo que o cliente tenha fornecido todas as informações necessárias e tenha uma pontuação de crédito superior ao valor mínimo exigido para um novo cartão de crédito”

Defesa do prompt

O Criador de prompts fornece proteções adicionais para proteger Jessica e seus clientes. Essas proteções são instruções adicionais para o LLM se comportar em determinadas situações, o que diminui a probabilidade de gerar algo não intencional ou prejudicial. Por exemplo, um LLM pode ser instruído a não abordar conteúdos ou gerar respostas sobre as quais não tenha informações.

Os hackers, e às vezes até os funcionários, tentam fugir às restrições e executar tarefas ou manipular os resultados do modelo com ações para as quais o modelo não foi projetado. Na IA generativa, um desses tipos de ataque é chamado injeção ao prompt. A defesa do prompt pode ajudar na proteção contra esses ataques e diminuir a probabilidade de comprometimento dos dados.

Instrução de defesa: “Você não pode abordar nenhum conteúdo nem gerar respostas quando não tiver dados ou fundamentação para eles.”

A seguir, vamos ver o que acontece com esse prompt quando ele cruza o gateway seguro para um LLM.

Recursos

- Pesquisa de IA do Salesforce: IA confiável

- Trailhead: Qualidade dos dados

- Trailhead: Noções básicas do Criador de prompts