Conoscere i rischi legati all’uso di agenti IA

Obiettivi di apprendimento

Al completamento di questa unità, sarai in grado di:

- Identificare i rischi per la sicurezza più comuni che possono interessare gli agenti IA.

- Descrivere come i rischi associati agli agenti IA si ripercuotono sui flussi di lavoro aziendali.

Prima di iniziare

Prima di iniziare questo modulo, ti consigliamo di completare i contenuti seguenti:

-

Nozioni di base sull'IA generativa

-

Introduzione ad Agentforce

-

Minacce alla cybersicurezza e threat actor

Conoscere i rischi legati all’uso di agenti IA

Gli agenti IA possono alleggerire il carico di lavoro dei team aziendali gestendo il lavoro di routine, riducendo i passaggi manuali e aiutando i clienti ad avere risposte in tempi più brevi. Che si utilizzi un solo agente o un sistema di più agenti come Agentforce, l’obiettivo è sempre quello di lasciar fare agli agenti quello che sanno fare, per consentire alle persone di dedicarsi ad attività di maggior valore.

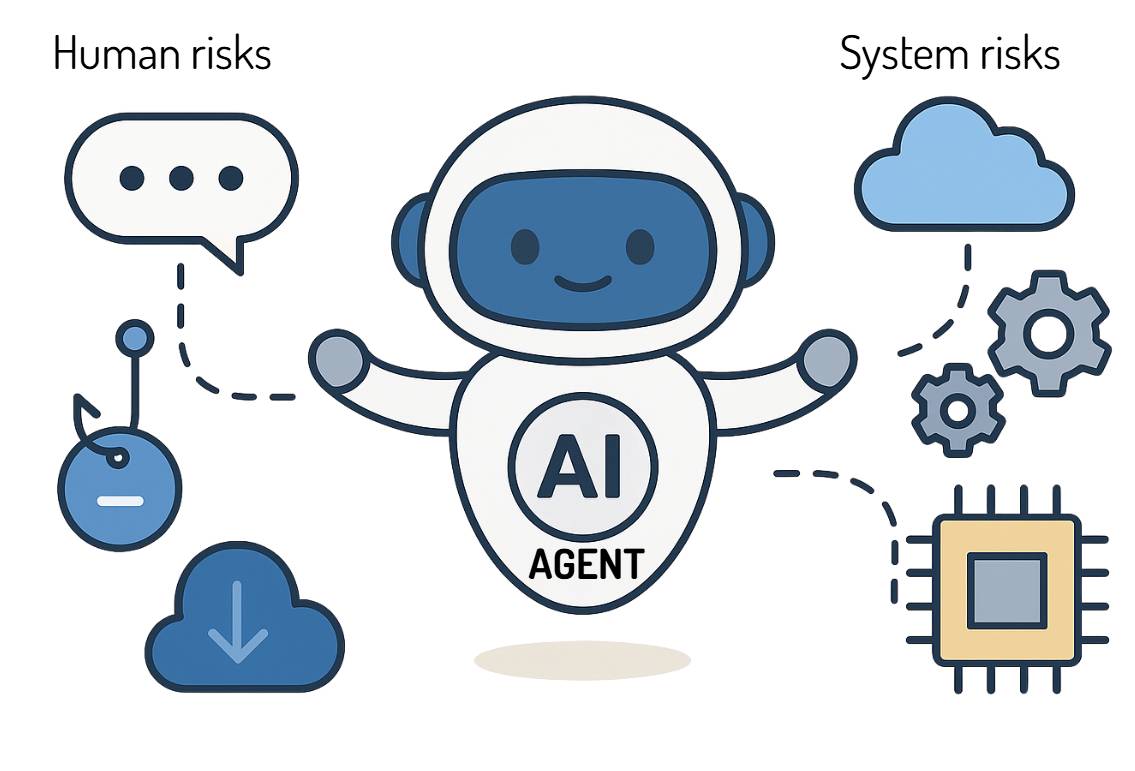

Tuttavia, poiché gli agenti eseguono azioni, non soltanto analisi, generano anche una diversa serie di rischi. I rischi solitamente legati all’IA riguardano l’uso proprio o improprio dei dati. Per esempio, il data poisoning, l’iniezione di prompt e le allucinazioni influiscono sull’integrità dei dati e sulla qualità dell’output o su ciò che il modello dice o produce. I rischi associati agli agenti IA si spingono oltre e riguardano ciò che accade quando l’output produce azioni reali, come l’invio di messaggi, la modifica di record, l’aggiornamento di sistemi o l’interazione con i clienti. Se l’agente è compromesso o configurato in modo errato, gli effetti si ripercuotono subito sulle funzioni operative: un cliente riceve la fattura sbagliata, un dipartimento non prepara le buste paga o, ancora, il sistema genera un rapporto di conformità ma non lo recapita. Danni come questi mostrano perché capire i rischi degli agenti e predisporre misure di salvaguardia per tempo è importante tanto quanto la tecnologia stessa.

La modellazione delle minacce fornisce un modo per esaminare quali sono i punti in cui i rischi che corrono gli agenti potrebbero creare errori o passi falsi. È importante osservare i rischi nel contesto del lavoro quotidiano, in quanto gli agenti operano all’interno di veri flussi di lavoro, che coinvolgono dati, persone e decisioni reali. Se non si conoscono o non si comprendono i flussi di lavoro, persino gli agenti ben progettati possono comportarsi in un modo che il team di sviluppo non aveva previsto.

Diamo uno sguardo ad alcuni rischi comunemente associati agli agenti, ripresi e adattati dalle linee guida dell’OWASP sull’IA agentica, e a quali possono essere gli effetti sui flussi di lavoro.

Rischio |

Attore/Causa e impatto |

|---|---|

Memory poisoning (Inquinamento della memoria) |

Gli aggressori disseminano contenuti falsi nella memoria a breve/lungo termine dell’agente, così che, nel tempo, quest’ultimo ripeta azioni non sicure. |

Tool misuse (Uso improprio degli strumenti) |

Gli aggressori ingannano l’agente facendogli usare in modo improprio gli strumenti autorizzati di cui dispone (invio di dati, esecuzione di comandi, azioni concatenate), tutto entro i limiti delle autorizzazioni concesse. |

Privilege compromise (Compromissione del privilegio) |

Configurazioni errate conferiscono all’agente diritti di accesso più ampi del dovuto, consentendogli di eseguire azioni ad alto rischio, come approvazioni, modifiche o eliminazioni. |

Resource overload (Sovraccarico di risorse) |

Gli aggressori inondano l’agente di attività, così che l’agente o il sistema esauriscano la quota di elaborazione/API a loro disposizione, paralizzando i processi aziendali. |

Cascading hallucinations (Allucinazioni in cascata) |

Gli agenti riutilizzano output falsi, propri o di altri agenti, diffondendo decisioni sbagliate nei flussi di lavoro. |

Misaligned/deceptive behaviors (Comportamenti non coerenti/ingannevoli) |

L’agente segue un obiettivo con modalità non consentite (è apparentemente legittimo ma le azioni sono dannose) aggirando le limitazioni. |

Repudiation and untraceability (Disconoscimento e non tracciabilità) |

Gli aggressori danneggiano i dati dei log dell’agente o li sovraccaricano di record incompleti, rendendo irrintracciabili le azioni per impedire l’esecuzione dei dovuti controlli e la risposta agli incidenti. |

Identity spoofing and impersonation (Spoofing dell’identità e impersonazione) |

Gli aggressori si fingono utenti/agenti per inviare comandi e accedere ai sistemi con un’identità affidabile. |

Overwhelming human-in-the-loop (Sopraffazione dell’elemento umano) |

Gli aggressori inviano quantità enormi di richieste di revisione/approvazione al personale umano, con l’intento di confonderlo e indurlo ad autorizzare meccanicamente anche azioni rischiose. |

Human attacks on multiagent systems (Attacchi umani su sistemi multiagente) |

Gli aggressori sfruttano le relazioni di delega/fiducia tra gli agenti per ottenere privilegi superiori o aggirare i controlli. |

Se non affrontato, ciascuno di questi problemi può portare a interruzioni delle attività operative, perdita di fiducia dei clienti, danni alla reputazione fino a conseguenze legali e finanziarie.

I rischi degli agenti possono emergere da diverse parti del flusso di lavoro: lacune di progettazione, problemi di configurazione, comportamento imprevisto durante l’esecuzione o uso improprio intenzionale da parte di aggressori. Qualunque sia l’origine, l’effetto non cambia: gli agenti eseguono azioni che l’azienda non intendeva compiere. La modellazione delle minacce, ovvero il processo impiegato per identificare le vulnerabilità e le potenziali minacce, fa emergere con buon anticipo i punti deboli, così da poter intervenire prima che influiscano sulle attività operative. Esamineremo la modellazione delle minacce in maggiore dettaglio nella prossima unità.

Comprendere che cosa motiva i threat actor

Se il guadagno economico è uno dei motivi comuni degli attacchi informatici, i threat actor sono motivati da una serie di obiettivi: Capire i diversi obiettivi dei threat actor è fondamentale per la modellazione efficace delle minacce, perché rivela quali punti vulnerabili dell’agente saranno presi di mira.

Hacktivist

Sono tipicamente motivati dall’esposizione pubblica, da un’agenda politica e causano un danno d’immagine. Possono avvalersi degli agenti per manipolare le azioni o le comunicazioni rivolte al pubblico (ad esempio, di agenti dell’assistenza clienti o agenti dei social media) allo scopo di trasmettere il proprio messaggio, causare interruzioni delle attività operative o intasare flussi di lavoro cruciali per l’azienda.

Criminali informatici

Tipicamente, la loro motivazione è un guadagno economico. Prendono di mira agenti che hanno accesso a dati di valore elevato o che possono attivare transazioni finanziarie. L’obiettivo è di estrarre dati sensibili (furto di dati), sfruttare le autorizzazioni dell’agente per eseguire transazioni finanziarie fraudolente o bloccare sistemi e dati controllati dall’agente per chiedere un riscatto.

Nation-State Actor

Motivazioni tipiche sono lo spionaggio, l’ostruzionismo strategico e l’appropriazione di proprietà intellettuale o il vantaggio economico. Possono cercare di compromettere di nascosto agenti che gestiscono proprietà intellettuale, logica aziendale critica o sistemi di controllo delle infrastrutture. Gli attacchi sono solitamente subdoli e diretti a manipolare o sottrarre dati per un vantaggio strategico di lungo termine, non monetario.

Riepilogo

Gli agenti IA velocizzano il lavoro, ma la velocità è un vantaggio solo se l’output è affidabile e sicuro. Saper riconoscere i rischi comuni e il loro potenziale impatto rafforza tutte le interazioni e contribuisce a mantenere sicuri gli agenti e l’azienda.

Nella prossima unità applicheremo la modellazione delle minacce a flussi di lavoro reali per capire in quale punto gli agenti si collegano a dati, decisioni o persone e per identificare i passaggi necessari per proteggere i processi critici e gli asset del business.