Die Aufforderungs-Journey

Lernziele

Nachdem Sie diese Lektion abgeschlossen haben, sind Sie in der Lage, die folgenden Aufgaben auszuführen:

- Erläutern, wie die Vertrauensebene Ihre Daten sicher handhabt

- Beschreiben, wie die dynamische Kontextbildung den Kontext einer Aufforderung verbessert

- Erklären, wie die Schutzmaßnahmen der Vertrauensebene Ihre Daten verteidigen

Trailcast

Wenn Sie sich eine Audioaufzeichnung dieses Moduls anhören möchten, nutzen Sie den nachstehenden Player. Denken Sie nach dem Anhören dieser Aufzeichnung daran, zur jeweiligen Lektion zurückzukehren, sich die Ressourcen anzusehen und die zugehörigen Aufgaben zu absolvieren.

Die Aufforderungs-Journey

Sie haben gerade ein wenig darüber erfahren, was die Vertrauensebene ist. Schauen wir uns nun an, wie sie sich in das Gesamtbild der generativen KI bei Salesforce einfügt. In dieser Einheit lernen Sie, wie sich eine Aufforderung auf ihrem Weg zum LLM durch die Einstein-Vertrauensebene bewegt.

Die Aufforderungsabsicherung steht in Prompt Builder (Aufforderungsgenerator), in der Prompt Template Connect API und der aufrufbaren Aktion "Prompt Template (Aufforderungsvorlage)" zur Verfügung.

Die Macht der Aufforderungen

Im Trailhead-Modul Aufforderungen – Grundlagen lernen Sie, dass Aufforderungen generative AI-Anwendungen antreiben. Sie lernen auch, dass klare Anweisungen, kontextbezogene Informationen und Einschränkungen helfen, eine großartige Aufforderung zu erstellen, die zu einer großartigen Antwort des LLMs führt. Um dies für unsere Kunden einfach und einheitlich zu gestalten, haben wir Aufforderungsvorlagen für alle Arten von Anwendungsfällen in Unternehmen, wie z. B. Vertriebs-E-Mails oder Antworten des Kundenservice, erstellt. Wenn von einer unserer Salesforce-Anwendungen eine Anforderung an die Vertrauensebene eingeht, ruft die Vertrauensebene eine entsprechende Aufforderungsvorlage auf.

Wir gehen jetzt einen Kundenservice-Anwendungsfall schrittweise durch, um die Aufforderungs-Journey darzustellen. Sie sehen die Aufforderungsvorlage und erleben, wie die Vorlage mit Kundendaten und relevanten Ressourcen gefüllt wird und die Einstein-Vertrauensebene Daten schützt, bevor sie zu einem externen LLM wechselt, um eine für die Aufforderung relevante Antwort zu generieren.

Wir stellen vor: Jessica

Jessica ist Kundendienstmitarbeiterin bei einem Kreditkartenunternehmen. Ihr Unternehmen hat gerade Service Replies implementiert, eine von Einstein unterstützte Funktion, die während des Chats mit dem Kunden Antwortvorschläge für Kundendienstmitarbeiter generiert. Jessica hat sich bereit erklärt, diese Funktion als eine der ersten Kundendienstmitarbeiterinnen auszuprobieren. Sie ist für ihre persönliche Note bei der Arbeit mit Kunden bekannt und ist daher ein wenig besorgt, dass die KI-generierten Antworten nicht zu ihrem Stil passen könnten. Sie möchte aber gerne Erfahrungen mit generativer KI zu ihrem Lebenslauf hinzufügen können und ist neugierig zu erfahren, ob sie mithilfe von Service Replies mehr Kunden helfen kann.

Jessica beginnt das Gespräch mit ihrem ersten Kunden des Tages, der Hilfe beim Upgrade seiner Kreditkarte benötigt. Service Replies macht die Antwortvorschläge direkt in der Servicekonsole. Die Antworten werden jedes Mal aktualisiert, wenn der Kunde eine neue Nachricht sendet, sodass sie im Kontext der Unterhaltung Sinn ergeben. Außerdem sind sie auf der Grundlage der in Salesforce gespeicherten Kundendaten für den Kunden personalisiert. Jeder Antwortvorschlag wird mithilfe einer Aufforderungsvorlage erstellt. Eine Aufforderungsvorlage enthält Anweisungen und Platzhalter, für die Geschäftsdaten eingetragen werden. In diesem Fall sind dies Daten zu Jessicas Kunden und dessen Supportvorgang sowie relevante Daten und Flows aus Jessicas Organisation. Die Aufforderungsvorlage befindet sich hinter der Salesforce-Vertrauensebene und ist für Jessica als Endbenutzerin in der Servicekonsole nicht sichtbar.

Sehen wir uns nun genauer an, wie diese Daten die Vertrauensebene durchlaufen, damit relevante, qualitativ hochwertige Antworten bereitgestellt und gleichzeitig die Kundendaten geschützt werden.

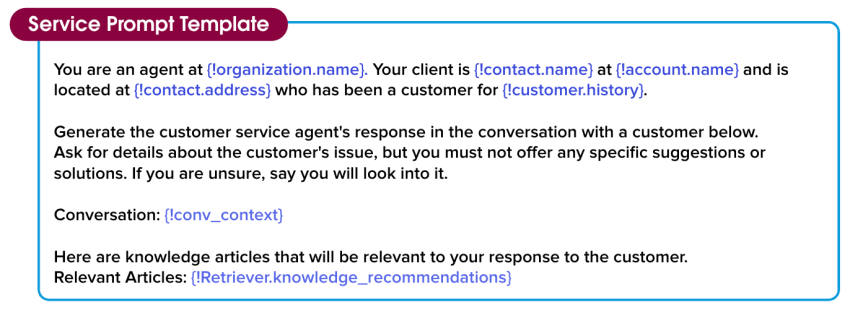

Du bist Agent bei {!organization.name}. Dein Kunde ist {!contact.name} bei {!account.name} in {!contact.address}, der seit {!customer.history} Kunde ist.

Generiere die Antwort des Kundendienstmitarbeiters im nachfolgenden Kundengespräch. Frage nach Einzelheiten zum Problem des Kunden, biete jedoch keine konkreten Vorschläge oder Lösungen an. Wenn du nicht sicher sind, sage, dass du die Sache prüfen wirst.

Unterhaltung: {!conv_context}

Die folgenden Knowledge-Artikel sind für deine Antwort an den Kunden relevant.

Relevante Artikel: {!Retriever.knowledge_recommendations}

Dynamische Kontextbildung

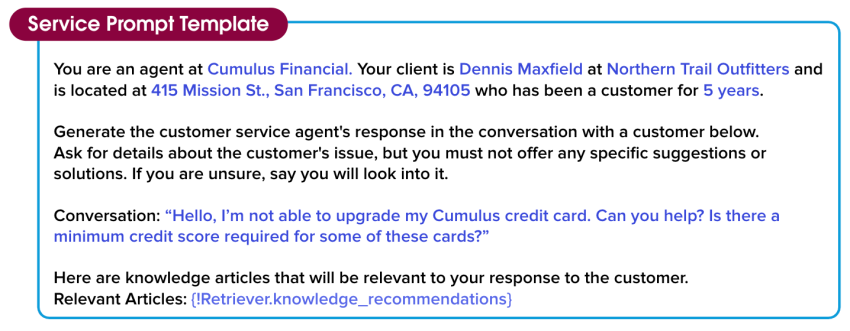

Für relevante, hochwertige Antworten sind relevante, hochwertige Eingabedaten erforderlich. Wenn Jessicas Kunde die Unterhaltung beginnt, verknüpft Service Replies die Unterhaltung mit einer Aufforderungsvorlage und fängt an, die Platzhalterfelder durch Seitenkontext, Briefvorlagenfelder und relevante Knowledge-Artikel aus dem Kundendatensatz zu ersetzen. Diesen Prozess bezeichnet man als dynamische Kontextbildung. Im Allgemeinen gilt: Je besser die Kontextbildung für eine Aufforderung ist, desto genauer und relevanter ist die Antwort. Die dynamische Kontextbildung macht Aufforderungsvorlagen wiederverwendbar, so dass sie für das gesamte Unternehmen skaliert werden können.

Die dynamische Kontextbildung beginnt mit dem sicheren Datenabruf, der relevante Daten über Jessicas Kunden aus ihrer Organisation identifiziert. Das Wichtigste dabei ist, dass beim sicheren Datenabruf alle Salesforce-Berechtigungen respektiert werden, die derzeit in Jessicas Organisation festgelegt sind und den Zugriff auf bestimmte Daten zu Objekten, Feldern und mehr einschränken. Dadurch wird sichergestellt, dass Jessica nur Informationen abruft, für die sie auch zugriffsberechtigt ist. Die abgerufenen Daten enthalten keine privaten Informationen oder andere Angaben, für die höhere Berechtigungen erforderlich sind.

Du bist Agent bei Cumulus Financial. Dein Kunde ist Dennis Maxfield bei Northern Trail Outfitters in 415 Mission St., San Francisco, CA, 94105, der seit 5 Jahren Kunde ist.

Generiere die Antwort des Kundendienstmitarbeiters im nachfolgenden Kundengespräch. Frage nach Einzelheiten zum Problem des Kunden, biete jedoch keine konkreten Vorschläge oder Lösungen an. Wenn du nicht sicher sind, sage, dass du die Sache prüfen wirst.

Unterhaltung:"Hallo! Ich kann kein Upgrade meiner Cumulus-Kreditkarte durchführen. Können Sie mir weiterhelfen? Ist eine bestimmte Bonitätseinstufung für diese Karte notwendig?"

Die folgenden Knowledge-Artikel sind für deine Antwort an den Kunden relevant.

Relevante Artikel: {!Retriever.knowledge_recommendations}

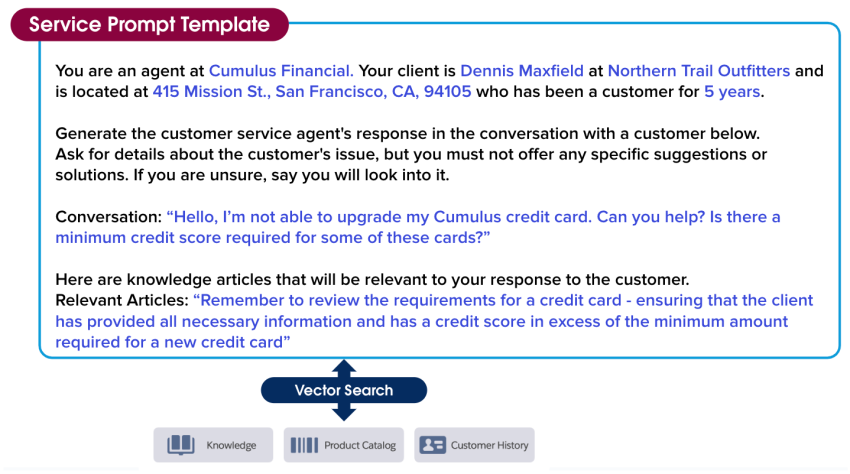

Semantische Suche

In Jessicas Fall genügen die Kundendaten, um das Gespräch zu personalisieren. Sie genügen jedoch nicht, um Jessica zu helfen, das Problem des Kunden schnell und effektiv zu lösen. Jessica benötigt Informationen aus anderen Datenquellen wie Knowledge-Artikeln und dem Kundenverlauf, um Fragen zu beantworten und Lösungen zu finden. Bei der semantischen Suche werden maschinelles Lernen und Suchmethoden eingesetzt, um relevante Informationen in anderen Datenquellen zu finden, die automatisch in die Aufforderung aufgenommen werden können. Das bedeutet, dass Jessica nicht manuell nach diesen Quellen suchen muss, was ihr Zeit und Arbeit erspart.

Hier hat die semantische Suche einen relevanten Knowledge-Artikel gefunden, der bei der Lösung des Kreditkartenproblems hilft, und hat den entsprechenden Ausschnitt des Artikels zur Aufforderungsvorlage hinzugefügt. Die Aufforderung nimmt jetzt schon richtig Form an!

Du bist Agent bei Cumulus Financial. Dein Kunde ist Dennis Maxfield bei Northern Trail Outfitters in 415 Mission St., San Francisco, CA, 94105, der seit 5 Jahren Kunde ist.

Generiere die Antwort des Kundendienstmitarbeiters im nachfolgenden Kundengespräch. Frage nach Einzelheiten zum Problem des Kunden, biete jedoch keine konkreten Vorschläge oder Lösungen an. Wenn du nicht sicher sind, sage, dass du die Sache prüfen wirst.

Unterhaltung:"Hallo! Ich kann kein Upgrade meiner Cumulus-Kreditkarte durchführen. Können Sie mir weiterhelfen? Ist eine bestimmte Bonitätseinstufung für diese Karte notwendig?"

Die folgenden Knowledge-Artikel sind für deine Antwort an den Kunden relevant.

Relevante Artikel: "Denke daran, die Anforderungen für eine Kreditkarte zu überprüfen, und stelle sicher, dass der Kunde alle erforderlichen Informationen zur Verfügung gestellt hat und eine Bonitätsbewertung besitzt, die über dem für eine neue Kreditkarte erforderlichen Minimum liegt."

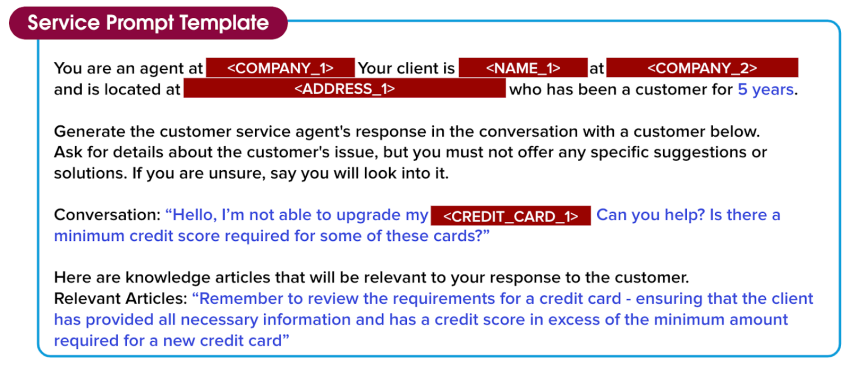

Datenmaskierung

Obwohl die Aufforderung genaue Daten über Jessicas Kunden und sein Problem enthält, kann sie noch nicht an das LLM übermittelt werden, da sie Informationen wie Namen und Adressen von Kunden und Auftraggebern enthält. Die Vertrauensebene sorgt durch Datenmaskierung für weitere Sicherheit von Jessicas Kundendaten. Bei der Datenmaskierung wird jeder Wert tokenisiert, so dass jeder Wert abhängig davon, wofür er steht, durch einen Platzhalter ersetzt wird. Dies bedeutet, dass das LLM den Kontext von Jessicas Gespräch mit ihrem Kunden beibehalten und dennoch eine relevante Antwort generieren kann.

Salesforce nutzt eine Mischung aus Musterabgleich und komplexen Verfahren für maschinengestütztes Lernen, um Kundendaten wie Namen und Kreditkarteninformationen intelligent zu erkennen und dann zu maskieren. Die Datenmaskierung erfolgt hinter den Kulissen. Jessica muss also nichts tun, um zu verhindern, dass die Daten ihres Kunden gegenüber dem LLM offengelegt werden. In der nächsten Einheit erfahren Sie, wie diese Daten wieder in die Antwort eingefügt werden.

Obwohl bei Salesforce eine Null-Datenaufbewahrungsrichtlinie für große Sprachmodelle von Drittanbietern gilt, erfordern es manche Unternehmen und Anwendungsfälle oder Vorschriften, dass sensible Daten überhaupt nicht an das LLM übermittelt werden. Jessica fragt bei ihrem Salesforce-Administrator nach, ob die Datenmaskierung aktiviert ist, da sie sicherstellen möchte, dass die ihre sensiblen Kundendaten nicht an das LLM übertragen werden.

Die Datenmaskierung für LLMs ist derzeit für Agenten deaktiviert. Für eingebettete generative KI-Funktionen wie Einstein Service Replies (Einstein-Service-Antworten) steht die Datenmaskierung bei "Einstein Work Summaries" (Einstein-Arbeitsübersichten) zur Verfügung, sodass Jessica diese Option für ihren Anwendungsfall verwenden kann.

Du bist Agent bei <COMPANY_1>. Dein Kunde ist <NAME_1> bei <COMPANY_2> in <ADDRESS_1>, der seit 5 Jahren Kunde ist.

Generiere die Antwort des Kundendienstmitarbeiters im nachfolgenden Kundengespräch. Frage nach Einzelheiten zum Problem des Kunden, biete jedoch keine konkreten Vorschläge oder Lösungen an. Wenn du nicht sicher sind, sage, dass du die Sache prüfen wirst.

Unterhaltung: "Hallo! Ich kann kein Upgrade meiner <CREDIT_CARD_1> durchführen. Können Sie mir weiterhelfen? Ist eine bestimmte Bonitätseinstufung für diese Karten notwendig? ”

Die folgenden Knowledge-Artikel sind für deine Antwort an den Kunden relevant.

Relevante Artikel: "Denke daran, die Anforderungen für eine Kreditkarte zu überprüfen, und stelle sicher, dass der Kunde alle erforderlichen Informationen zur Verfügung gestellt hat und eine Bonitätsbewertung besitzt, die über dem für eine neue Kreditkarte erforderlichen Minimum liegt."

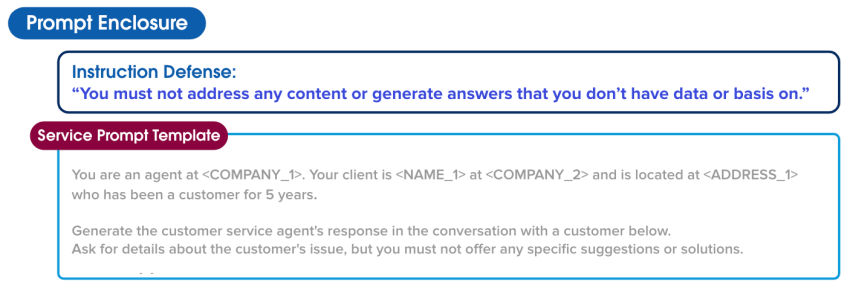

Aufforderungsabsicherung

Prompt Builder (Aufforderungsgenerator) bietet weitere Schutzmaßnahmen, um Jessica und ihre Kunden zu schützen. Diese Schutzmaßnahmen sind weitere Anweisungen an das LLM, die festlegen, wie es sich in bestimmten Situationen verhalten soll, um die Wahrscheinlichkeit zu verringern, dass es etwas Unbeabsichtigtes oder Schädliches ausgibt. So könnte ein LLM beispielsweise angewiesen werden, keine Inhalte anzusprechen oder Antworten zu generieren, zu denen es keine Informationen hat.

Hacker und manchmal auch Mitarbeiter versuchen immer wieder, Beschränkungen zu umgehen und Aufgaben auszuführen oder die Modellausgabe auf eine Weise zu manipulieren, für die das Modell nicht konzipiert wurde. Bei der generativen KI wird eine dieser Angriffsarten als Prompt Injection bezeichnet. Die Aufforderungsabsicherung kann zum Schutz vor solchen Angriffen beitragen und die Wahrscheinlichkeit verringern, dass Daten kompromittiert werden.

Anweisungsabsicherung: Sprich keine Inhalte an und gibt keine Antworten, für die keine Daten oder Grundlagen vorliegen.

Als Nächstes sehen wir uns an, was mit dieser Aufforderung passiert, wenn sie über das sichere Gateway in ein LLM gelangt.

Ressourcen

- Salesforce-AI-Forschung: Vertrauenswürdige KI

- Trailhead: Datenqualität

- Trailhead: Prompt Builder (Aufforderungsgenerator) – Grundlagen