信頼計画を立てる

学習の目的

この単元を完了すると、次のことができるようになります。

- プロジェクトの AI リスクを評価して、リスクプロファイルを作成する。

- リスクプロファイルに基づいてガードレールを実装する。

Trailcast

このモジュールの音声録音をお聞きになりたい場合は、下記のプレーヤーを使用してください。この録音を聞き終わったら、必ず各単元に戻り、リソースを確認して関連付けられている評価を完了してください。

信頼を第一に考える

AI は特定のリスクを伴います。だとしたら、各自の AI ソリューションが倫理的かつ安全で、責任ある方法で使用されるかどうかはどうすればわかるのでしょうか? 信頼計画を作成すれば確認できます。

プロジェクトの信頼計画は、機密データの安全性の確保、規制要件の遵守、会社の評判の保全などの方法で信頼に対するリスクを緩和する対策です。

信頼計画を定義する最初のステップは、プロジェクトのリスクプロファイルを作成することです。リスクプロファイルを確認すれば、プロジェクトのリスクへの対処とその優先度がわかるようにします。このプロファイルには、リスクの種類とレベル、悪影響が生じる可能性、各種のリスクによる中断やコストの程度が記載されます。効果的なリスクプロファイルには、どのリスクを優先すべきかも示されます。

リスクの領域

リスクプロファイルを作成するときは、データの漏洩、規制要件、評判の低下という 3 つの主要なリスク領域に関する質問に回答します。一例として、Becca は自分のプロジェクトについて以下の質問に次のように答えています。

リスク領域 |

説明 |

質問 |

Becca の回答 |

|---|---|---|---|

データの漏洩 |

データの漏洩が生じるのは、安全な情報が誤って開示されたときです。この原因として、サイバー攻撃、不正アクセス、外部の AI モデルへの機密データの開示が挙げられます。データの漏洩を防ぐために、データを安全に保管し、許可されたユーザーのみがアクセスできるようにします。このリスク領域には、個人識別情報 (PII) などの機密データの保護も含まれます。 |

|

Coral Cloud にはデータを保管する安全なシステムがあることを Becca は 知っています。その一方で、Becca のプロジェクトは「人間参加型」で、人間が Einstein にゲストをチェックインするよう指示すると、チェックインプロセスがトリガーされます。 この実行ユーザーはゲストがいつ、どこに滞在するかを知り得るため、このときにデータが漏洩するおそれがあると Becca は考えます。許可されていない人にこうした情報が漏洩すれば、危険な事態を招きます。 Becca のプロジェクトでは、氏名、連絡先情報、クレジットカード情報などの機密データを扱います。 |

規制要件 |

プロジェクトが、事業を展開している管轄や業界の法的要件を満たしていることを確認します。すべての規制を満たしていなければ、罰金、評判の低下、その他の法的影響を受けるおそれがあります。最初の単元で挙げたリーガルチームが、あらゆる規制を特定して遵守するようサポートしてくれます。 |

|

Coral Cloud は欧州で事業を運営しているため、Becca のプロジェクトは一般データ保護規則 (GDPR) に準拠する必要があります。Becca はリーガルチームに連絡して、他にどのような規制に従う必要があるか調べてもらいます。 |

評判の低下 |

この AI プロジェクトはお客様とやりとりする際、会社を代表してお客様に対応します。データセットに有害性や技術攻撃が潜んでいれば、AI が有害または誤った応答を生成するおそれがあります。 |

|

AI が生成したウェルカムメールに不快な言葉が含まれていれば、Coral Cloud は無礼で敵対的とみなされ、 現在および将来の大切なお客様を失うことになります。ホスピタリティ業界では評判の失墜が深刻な問題であることを Becca は認識しています。 |

リスクプロファイルを作成する

Becca は各リスク領域の評価に基づいて、プロジェクトのリスクプロファイルを作成します。「1」はリスクが極めて低く、「5」はリスクが極めて高いことを示します。

リスク種別 |

悪影響の程度 |

悪影響が生じる可能性 |

中断またはコスト |

|---|---|---|---|

データの漏洩 |

4: データが漏洩すれば、ゲストの安全性とプライバシーが損なわれます。 |

3: Coral Cloud のデータは安全に保管されていますが、このリスク対策を強化するために他のコントロールを導入する必要があります。 |

4: お客様の信頼の喪失 |

規制要件 |

5: Coral Cloud が罰金その他の法的措置や、お客様の信頼の喪失に直面します。 |

5: Becca のプロジェクトが規制を遵守しなければ、Coral Cloud に悪影響が及ぶ可能性が極めて高くなります。 |

5: 法的措置、罰金、お客様の信頼の喪失 |

評判の低下 |

5: Coral Cloud の評判が低下すれば、潜在的なゲストと利益を失います。 |

4: Becca はプロンプトを改良し、評判の低下を阻止する他の方法を導入する必要があります。 |

4: お客様の信頼の喪失 |

Becca はリスクプロファイルに基づいて、規制要件、評判の低下、データの漏洩という優先順位にしました。続いて、各リスクにどのように対処するか計画を立て始めます。

ガードレールの種別

リスクを認識したら、AI ガードレールを実装します。AI ガードレールとは、AI プロジェクトが合法的かつ倫理的な方法で運用されていることを保証するメカニズムです。バイアスのかかった判断、有害な言葉、データの開示などによって AI が害悪を及ぼさないようにするためにはガードレールが必要です。プロジェクトを技術攻撃から守るためにもガードレールが欠かせません。

AI ガードレールには、セキュリティガードレール、テクニカルガードレール、倫理的ガードレールの 3 種類があります。

セキュリティガードレール

プロジェクトが法規制に準拠していることや、個人のデータや人権が保護されていることを保証します。一般的なツールとして、セキュアなデータ取得、データマスキング、データ保持ゼロなどが挙げられます。

セキュアなデータ取得とは、各自のプロジェクトが、実行ユーザーにアクセスが許可されているデータにしかアクセスできないということです。たとえば、財務レコードへのアクセス権がないユーザーが AI モデルからの応答をトリガーした場合、モデルは財務レコードに関連するデータを取得できません。データマスキングとは、機密データを外部モデルに開示する前にプレースホルダーデータに置き換えることです。マスキングによって機密データが漏洩するおそれがなくなります。データ保持ゼロポリシーはモデルプロバイダーが適用します。つまり、モデルにはタスクを実行する時点しか必要なデータが保存されません。応答が生成されると使用されたデータが消去されます。

テクニカルガードレール

プロンプトの挿入や脱獄など、ハッカーが仕掛ける技術攻撃や、モデルに機密情報を開示させる他の手口からモデルを守ります。サイバー攻撃により、モデルが不正確または有害な応答を生成することがあります。

倫理的ガードレール

プロジェクトが人間のバリューと常に一致しているようにします。たとえば、有害性やバイアスのスクリーニングを実施します。

有害性とは、AI モデルで憎悪的、虐待的、冒涜的 (HAP) またはわいせつなコンテンツが生成されることです。バイアスとは、AI に人種や性別のステレオタイプなど、有害なステレオタイプが反映されることです。ご存知のとおり、こうした内容は大問題になります! AI はその応答を学習するため、有害性やバイアスが生じたときは、データからモデルに望ましくない言葉や概念が取り込まれていることを示す兆候である可能性があります。有害検出で有害な言葉を含む可能性がある応答が特定された場合には、手作業でその応答を確認し、有害性が軽減されるように調整します。

これで、ガードレールの概要と、ガードレールでプロジェクトをリスクから守る方法がわかりました。次は、Becca が信頼計画にガードレールをどのように実装するのか見ていきます。

Coral Cloud の信頼計画

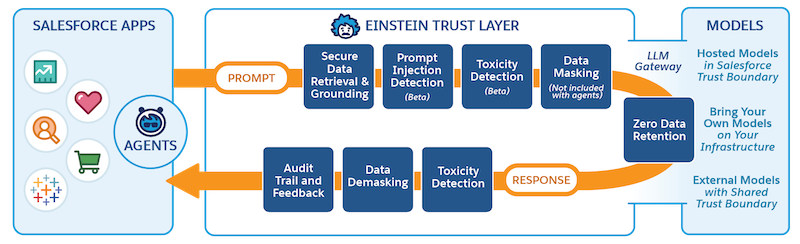

信頼計画の実装方法は、使用しているシステムによって異なります。Becca は Salesforce を使用しているため、信頼計画は Einstein Trust Layer 上に構築されます。Trust Layer は、Salesforce エコシステム全体でデータのプライバシーを保護し、AI の正確性を高め、AI の責任ある使用を促進することを目的に設計された機能、プロセス、ポリシーの集合体です。Becca のプロジェクトのプロンプトビルダーなど、Einstein 生成 AI 機能を使用して作成したプロジェクトは、自動的に Trust Layer を経由します。

Becca は Trust Layer の機能を使用して、各リスク領域に対処する信頼計画を定義します。また、望ましい成果も想定します。以下は、Becca の信頼計画の抜粋です。

リスク領域 |

Becca の信頼計画 |

Trust Layer の機能 |

成果 |

|---|---|---|---|

データの漏洩 |

|

|

|

評判の低下 |

|

|

|

Becca は信頼計画を確定する前に、リーガルチームやセキュリティチームとミーティングを行い、不備がないことを確認します。

次のステップ

信頼計画の完成をもって Becca のプロジェクトの計画フェーズは終了です! 構築フェーズに進んで、プロジェクトを Salesforce に実装することができます。「Data 360 を Agentforce とプロンプトビルダーに接続する」で、Becca のプロジェクトを続行します。

各自のプロジェクトを構築する際、リスクは一度緩和すれば済む問題ではない点に留意します。プロジェクトを実装後も、リスクを継続的に監視して監査します。監視していれば、問題のあるトレンドを早期に発見して調整できます。有害性スコアとフィードバックを確認して、ソリューションのどこで問題が発生したかを特定し、リスク要因を排除するために調整します。

まとめ

このモジュールでは、AI プロジェクトを準備する際の重要な手順について説明しました。これで、プロジェクトの関係者を特定し、目標を設定して、テクニカルソリューションを選択する方法がわかりました。また、質の高いデータを準備し、プロジェクトの要件を満たす方法も理解しました。さらに、信頼計画を定めればプロジェクトのリスクが緩和されることと、リスクを監視することが重要である理由も認識しました。

こうした新しい知識を携えて、効果的な AI プロジェクトの立ち上げに向けて前進していきます! ロールアウトを開始する前に、必ず「AI 実装の変更管理」モジュールを受講してください。

リソース

- PDF: NIST: Artificial Intelligence Risk Management Framework (人工知能のリスク管理フレームワーク)

- Excel スプレッドシート: NIST: AI Risk Assessment Template (AI リスク評価テンプレート)

- PDF: Building Trust in AI with a Human at the Helm (人間主導型の AI に信頼を構築する)

- Trailhead: AI 実装の変更管理

- Trailhead: Einstein Trust Layer

- 記事: AI-Powered Cyberattacks (AI を利用したサイバー攻撃)

- 記事: Understanding Why AI Guardrails Are Necessary: Ensuring Ethical and Responsible AI Use (AI ガードレールが必要な理由を理解する: 倫理的かつ責任ある AI の使用を徹底する)

- PDF: Mitigating LLM Risks Across Salesforce’s Gen AI Frontiers (Salesforce の生成 AI 最前線の LLM リスクを緩和する)