Introduzione a Einstein Trust Layer

Obiettivi di apprendimento

Al completamento di questa unità, sarai in grado di:

- Illustrare il valore numero 1 di Salesforce: la fiducia.

- Descrivere gli elementi problematici relativi alla fiducia e all'IA generativa.

- Spiegare perché Salesforce ha creato Einstein Trust Layer.

Trailcast

Se vuoi ascoltare una registrazione di questo modulo, usa il player qui sotto. Quando hai finito, ricorda di tornare a ciascuna unità, consultare le risorse e completare le valutazioni associate.

Prima di iniziare

Sappiamo che attendi con ansia di sapere in che modo Salesforce protegge i dati della tua azienda e dei tuoi clienti mentre introduciamo nuovi strumenti di intelligenza artificiale (IA) generativa. Ma, prima di iniziare, è opportuno acquisire familiarità con i concetti e la terminologia coperti nei badge seguenti.

-

Nozioni di base sull'IA generativa

-

Nozioni di base sull'elaborazione del linguaggio naturale

-

Large Language Model

-

Nozioni fondamentali sui prompt

Anche il Glossario dei termini Agentforce tratta diversi termini usati in questo badge, tra cui LLM, prompt, radicamento nel contesto, allucinazioni, linguaggio tossico e molti altri.

IA generativa, Salesforce e fiducia

Tutti sono entusiasti dell'IA generativa perché libera la loro creatività in modi completamente nuovi. Lavorare con l'IA generativa può essere molto divertente, ad esempio se usi Midjourney per creare immagini del tuo cucciolo in versione supereroe o ChatGPT per inventare una poesia scritta da un pirata. Le aziende sono entusiaste dell'IA generativa perché consente di aumentare la produttività. Secondo una ricerca di Salesforce, i dipendenti prevedono che l'IA generativa farà risparmiare loro in media cinque ore alla settimana. Per i dipendenti a tempo pieno, parliamo di un mese intero all'anno.

Tuttavia, a fronte di tutto questo entusiasmo, probabilmente hai qualche domanda. Ad esempio:

- Come faccio a sfruttare gli strumenti che l'IA generativa mette a mia disposizione e mantenere al sicuro i miei dati e quelli dei miei clienti?

- Come faccio a sapere quali dati vengono raccolti dai diversi fornitori di IA generativa e come vengono utilizzati?

- Come posso avere la certezza che non sto consegnando accidentalmente dati personali o aziendali per addestrare modelli di intelligenza artificiale?

- Come faccio a verificare che le risposte generate dall'IA siano accurate, imparziali e affidabili?

Salesforce e la fiducia

In Salesforce, ci siamo posti le stesse domande sull'IA e la sicurezza. In realtà, abbiamo abbracciato l'IA da quasi un decennio. Nel 2016 abbiamo lanciato la piattaforma Einstein, portando l'IA predittiva nei nostri cloud. Poco dopo, nel 2018, abbiamo iniziato a investire nei Large Language Model (LLM, modelli linguistici di grandi dimensioni).

Ci siamo impegnati a fondo nella creazione di soluzioni di IA generativa per aiutare i nostri clienti a utilizzare i loro dati in modo più efficiente e ad aumentare la produttività e l'efficienza di aziende, dipendenti e clienti. E poiché la fiducia è il nostro valore numero 1, crediamo che non sia sufficiente fornire soltanto le capacità tecnologiche dell'IA generativa. Riteniamo di avere il dovere di assicurare serietà, responsabilità, trasparenza, utilità e inclusività. Ecco perché, nello sviluppare strumenti di IA generativa, portiamo con noi il valore della fiducia.

Qui entra in scena Einstein Trust Layer. Abbiamo creato il Trust Layer per aiutare te e i tuoi colleghi a utilizzare l'IA generativa nella vostra organizzazione in modo sicuro e protetto. Vediamo come agisce Salesforce per far sì che la sua IA generativa sia la più sicura del settore.

Cos'è Einstein Trust Layer?

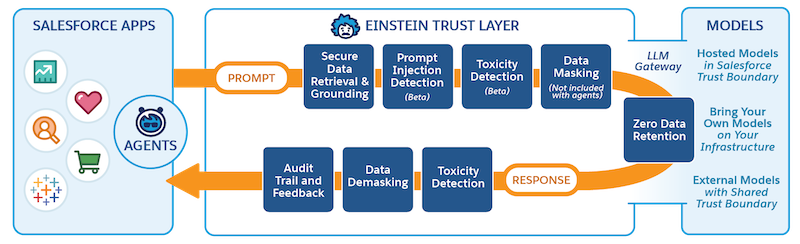

Einstein Trust Layer porta la sicurezza dell'IA generativa a un nuovo livello attraverso controlli sui dati e sulla privacy perfettamente integrati nell'esperienza dell'utente finale. Questi controlli consentono a Einstein di fornire un'intelligenza artificiale radicata in modo sicuro nel contesto dei dati dei clienti e dell'azienda, senza introdurre potenziali rischi per la sicurezza. Nella sua forma più semplice, il Trust Layer è una sequenza di gateway e meccanismi di recupero che, insieme, danno vita a un'IA generativa aperta e affidabile.

Grazie a Einstein Trust Layer, i clienti usufruiscono dei vantaggi dell'IA generativa senza rischiare la compromissione della sicurezza dei loro dati e dei controlli per la privacy. Einstein Trust Layer include una serie di funzionalità per la protezione dei dati, tra cui il recupero sicuro, il Dynamic Grounding, il mascheramento e la non conservazione dei dati, in modo che non occorra preoccuparsi di dove possano andare a finire. Il rilevamento del linguaggio tossico analizza i prompt e le risposte per verificarne l'accuratezza e l'adeguatezza. Inoltre, per maggiore trasparenza, i prompt vengono tracciati in ogni fase del loro percorso attraverso un audit trail. Nelle prossime unità approfondirai le tue conoscenze su ciascuna di queste funzionalità.

Attualmente, il mascheramento dei dati è disabilitato per gli agenti. Il mascheramento dei dati è disponibile per le funzionalità incorporate basate sull'IA generativa, come Risposte sul servizio Einstein e Riepiloghi lavoro Einstein, ed è possibile configurarlo nelle impostazioni di Einstein Trust Layer.

Abbiamo progettato il nostro ecosistema di modelli aperti in modo che tu possa accedere in sicurezza a svariati modelli linguistici di grandi dimensioni (LLM), sia all'interno che all'esterno di Salesforce. Il Trust Layer si inserisce tra un LLM e dipendenti e clienti per mantenere i dati al sicuro durante l'utilizzo dell'IA generativa per tutti i casi d'uso aziendali, tra cui le email promozionali, i riepiloghi di lavoro e le risposte dell'assistenza nel contact center.

Nelle prossime unità, potrai esaminare a fondo i percorsi dei prompt e delle risposte per scoprire come Einstein Trust Layer protegge i tuoi dati.

Risorse

- Documentazione: Glossario dei termini dell'IA generativa Einstein

- Blog: Meet Salesforce’s Trusted AI Principles (Ti presentiamo i principi dell'IA affidabile di Salesforce)

- Blog: Generative AI: 5 Guidelines for Responsible Development (IA generativa: 5 linee guida per lo sviluppo responsabile)

- Trailhead: Creare intelligenza artificiale in modo responsabile

- Trailhead: Nozioni di base sull'IA generativa

- Trailhead: Elaborazione del linguaggio naturale

- Trailhead: Large Language Model

- Trailhead: Nozioni fondamentali sui prompt