Pianificare la strategia per la fiducia

Obiettivi di apprendimento

Al completamento di questa unità, sarai in grado di:

- Creare un profilo di rischio vagliando i rischi associati all'IA per un progetto.

- Implementare misure di salvaguardia in base al profilo di rischio.

Trailcast

Se vuoi ascoltare una registrazione di questo modulo, usa il player qui sotto. Quando hai finito, ricorda di tornare a ciascuna unità, consultare le risorse e completare le valutazioni associate.

Introduzione alla fiducia

L'IA comporta alcuni rischi. Come si fa a stabilire se una soluzione di IA è etica, sicura e responsabile? Creando una strategia per la fiducia.

La strategia per la fiducia di un progetto è un piano per mitigare i rischi per la fiducia, ad esempio: assicurare la protezione dei dati sensibili, soddisfare requisiti normativi e proteggere la reputazione della propria azienda.

Il primo passo per la definizione di una strategia per la fiducia è creare un profilo di rischio per il proprio progetto. Un profilo di rischio fornisce gli strumenti per gestire i rischi associati a un progetto e stabilire la loro priorità e copre il tipo e il livello dei rischi, la probabilità che si verifichino effetti negativi e il livello dei disagi o dei costi che ciascun tipo di rischio comporta. Un profilo di rischio efficace consente di stabilire a quali rischi dare priorità.

Aree di rischio

Per creare un profilo di rischio, occorre rispondere a domande associate a tre aree di rischio principali: fughe di dati, requisiti normativi e danni alla reputazione. Per esempio, ecco come Becca risponde a queste domande per il suo progetto:

Area di rischio |

Descrizione |

Domande da porre |

Risposta di Becca |

|---|---|---|---|

Fughe di dati |

Le fughe di dati si verificano quando informazioni protette vengono accidentalmente esposte. Questo può accadere in seguito ad attacchi informatici e accessi non autorizzati e attraverso l'esposizione di dati sensibili a modelli di IA esterni. Per impedire le fughe di dati, è necessario archiviarli in modo sicuro e accertarsi che solo gli utenti autorizzati possano accedervi. Quest'area di rischio comprende anche la protezione di dati sensibili, ad esempio le informazioni personali (PII, Personally Identifiable Information). |

|

Becca sa che Coral Cloud utilizza un sistema protetto per l'archiviazione dei dati. Tuttavia, il suo progetto prevede l'intervento o l'interazione umani, attraverso cui una persona innesca il processo di accettazione dicendo ad Einstein di effettuare l'accettazione di un cliente. Becca si rende conto che in questo caso esiste la possibilità di fughe di dati, in quanto l'utente può scoprire dove alloggia l'ospite e in quali date. Si tratta di informazioni pericolose se vengono divulgate a una persona non autorizzata. Nel progetto di Becca sono inclusi dati sensibili come nomi e cognomi, informazioni di contatto e dati relativi alle carte di credito. |

Requisiti normativi |

È necessario accertarsi che il progetto soddisfi i requisiti legali in vigore nella giurisdizione e nel settore in cui opera. Se non si rispettano tutte le norme, si è esposti a sanzioni, danni alla reputazione e altre ripercussioni di carattere legale. Il team legale identificato nella prima unità può contribuire a individuare e a ottemperare a tutte le normative. |

|

Dal momento che Coral Cloud opera nell'Unione Europea, il progetto di Becca deve rispettare il Regolamento generale sulla protezione dei dati (GDPR, General Data Protection Regulation). Becca si rivolge al team legale per chiedere loro di verificare quali altre normative vanno rispettate. |

Danni alla reputazione |

Poiché interagisce con i clienti, il progetto di IA rappresenta la voce dell'azienda. L'IA può talvolta generare risposte dannose o false a causa di tossicità del set di dati o di attacchi tecnici. |

|

Se nelle email di benvenuto generate dall'IA è presente linguaggio offensivo, Coral Cloud verrà percepita come un'azienda insolente e ostile e perderà preziosi clienti acquisiti e potenziali. Becca sa che nel settore ricettivo i danni alla reputazione sono un problema serio. |

Creare di un profilo rischio

Becca crea un profilo rischio per il suo progetto in base alla sua valutazione delle diverse aree di rischio. Nel profilo, 1 rappresenta un rischio molto basso e 5 un rischio molto alto.

Tipo di rischio |

Livello degli effetti negativi |

Probabilità degli effetti negativi |

Disagi o costi |

|---|---|---|---|

Fughe di dati |

4: se si verificano fughe di dati, la sicurezza e la privacy degli ospiti sono compromesse. |

3: i dati di Coral Cloud sono archiviati in modo sicuro, ma è opportuno adottare ulteriori misure per rafforzare la protezione contro questo rischio. |

4: perdita della fiducia dei clienti. |

Requisiti normativi |

5: Coral Cloud è esposta a sanzioni o altre conseguenze legali e alla perdita della fiducia dei propri clienti. |

5: se il progetto di Becca non rispetta le normative è molto probabile che Coral Cloud sia esposta a conseguenze negative. |

5: conseguenze legali, sanzioni e perdita della fiducia dei clienti. |

Danni alla reputazione |

5: Coral Cloud perderà ospiti potenziali e profitti se la sua reputazione viene danneggiata. |

4: Becca deve perfezionare il prompt e implementare altre misure per assicurare che la reputazione dell'azienda non subisca danni. |

4: perdita della fiducia dei clienti. |

In base al profilo di rischio, Becca decide di dare la massima priorità ai requisiti normativi, seguiti dai danni alla reputazione e, infine, dalle fughe di dati. Quindi inizia a pianificare il modo in cui andranno gestiti questi rischi.

Tipi di misure di salvaguardia

Una volta identificati i rischi, è necessario implementare misure di salvaguardia per l'IA. Queste sono costituite da meccanismi che assicurano che il progetto di IA funzioni in modo legale ed etico. Le misure di salvaguardia sono necessarie per impedire che l'IA provochi danni attraverso decisioni caratterizzate da bias, utilizzo di linguaggio tossico ed esposizione di dati. Le misure di salvaguardia sono necessarie per proteggere il progetto da attacchi tecnici.

I tipi di misure di salvaguardia per l'IA sono tre: salvaguardia della sicurezza, salvaguardia tecnica e salvaguardia etica.

Misure di salvaguardia della sicurezza

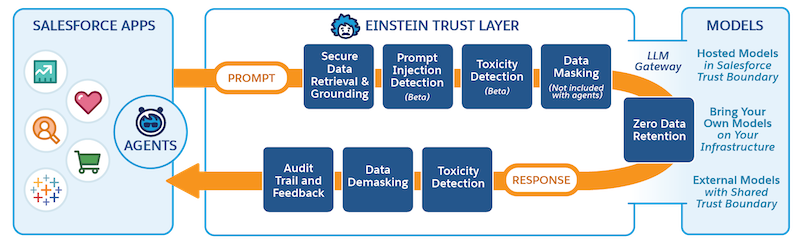

Queste misure di salvaguardia assicurano che il progetto sia conforme alle leggi e alle normative e che la privacy e i diritti umani siano protetti. Gli strumenti più diffusi in questo ambito comprendono il recupero protetto dei dati, il mascheramento dei dati e la conservazione dei dati azzerata.

Recupero protetto dei dati vuol dire che il progetto accederà solo ai dati cui l'utente che invia una richiesta è autorizzato ad accedere. Ad esempio, se una persona che non ha accesso ai record finanziari innesca una risposta dal modello di IA, il modello non deve recuperare dati correlati ai record finanziari. Mascheramento dei dati vuol dire che i dati sensibili sono sostituiti con segnaposto prima che vengano esposti a modelli esterni. In questo modo si elimina il rischio che vengano divulgati dati sensibili. I provider dei modelli applicano politiche di conservazione dei dati azzerata, ossia: i dati non vengono archiviati oltre le necessità immediate di una data attività. Quindi, una volta che la risposta è stata generata, i dati utilizzati scompaiono.

Misure di salvaguardia tecnica

Queste misure di salvaguardia proteggono il progetto da attacchi tecnici lanciati da hacker, come l'iniezione di prompt, il jailbreaking o altri metodi volti a forzare il modello in modo che esponga informazioni sensibili. Il progetto potrebbe generare risposte false o dannose a causa di attacchi informatici.

Misure di salvaguardia etica

Queste misure di salvaguardia assicurano che il progetto sia in linea con i valori umani e includono la protezione da tossicità e bias.

La tossicità si presenta quando un modello di IA genera contenuti carichi di odio, offensivi, volgari oppure osceni. Il bias si configura quando l'IA riflette stereotipi dannosi, ad esempio razziali o di genere, con conseguenze prevedibilmente disastrose. Poiché l'IA apprende dalle proprie risposte, la tossicità e il bias potrebbe essere un sintomo che indica che i dati utilizzati introducono linguaggio e idee indesiderati nel modello. Attraverso il rilevamento della tossicità è possibile identificare risposte che possono contenere linguaggio tossico in modo da poterle rivedere manualmente e apportare modifiche per ridurre la tossicità.

Ora che sai cosa sono le misure di salvaguardia e in che modo proteggono il tuo progetto dai rischi, vediamo come Becca le implementa nella sua strategia per la fiducia.

La strategia per la fiducia di Coral Cloud

L'implementazione di una strategia per la fiducia è diversa a seconda del sistema che si utilizza. Poiché Becca utilizza Salesforce, la sua strategia per la fiducia è basata su Einstein Trust Layer, un insieme di funzionalità, processi e criteri progettato per salvaguardare la privacy dei dati, migliorare l'accuratezza dell'IA e promuovere il suo utilizzo responsabile in tutto l'ecosistema Salesforce. Quando si utilizzano le funzionalità di IA generativa Einstein, ad esempio il Generatore di prompt nel progetto di Becca, il progetto passa automaticamente attraverso il Trust Layer.

Becca definisce una strategia per la fiducia che affronta ciascuna area di rischio utilizzando le funzionalità del Trust Layer e visualizza inoltre il risultato desiderato. Ecco un estratto della sua strategia per la fiducia.

Area di rischio |

Strategia per la fiducia di Becca |

Funzionalità di Trust Layer |

Risultato |

|---|---|---|---|

Fughe di dati |

|

|

|

Danni alla reputazione |

|

|

|

Prima di completare la sua strategia per la fiducia, Becca incontra il team legale e quello per la sicurezza per accertarsi che non ci siano lacune.

Fasi successive

Una volta messa a punto la strategia per la fiducia, Becca ha completato la pianificazione del suo progetto ed è pronta per iniziare la fase di sviluppo in cui implementerà il progetto in Salesforce. Continua a seguire il progetto di Becca in Connettere Data 360 ad Agentforce e al Generatore di prompt.

Durante l'elaborazione del tuo progetto, tieni presente che la mitigazione dei rischi non è un'attività che viene completata a una volta per tutte. Dopo aver implementato il progetto, è necessario monitorare e controllare i rischi costantemente. Il monitoraggio consente di identificare in anticipo tendenze problematiche e apportare le rettifiche necessarie. È opportuno esaminare i punteggi relativi alla tossicità e il feedback per identificare gli aspetti problematici della soluzione e modificarla in modo da eliminare i fattori di rischio.

Riepilogo

Questo modulo illustra i passaggi fondamentali nella preparazione di un progetto di IA. Ora sai come identificare gli stakeholder del progetto, stabilire gli obiettivi e scegliere una soluzione tecnica. Hai appreso come preparare dati di alta qualità e soddisfare i requisiti del progetto, in che modo una strategia per la fiducia mitiga i rischi associati al progetto e perché è importante monitorare i rischi.

Con queste nuove competenze sei sulla buona strada per lanciare un progetto di IA di successo! Prima di passare all'implementazione, completa il modulo Gestione dei cambiamenti per l'implementazione dell'IA.

Risorse

- PDF: NIST Artificial Intelligence Risk Management Framework (Framework di gestione del rischio dell'IA del NIST)

- Foglio di calcolo Excel: NIST AI Risk Assessment Template (Modello del NIST per la valutazione dei rischi dell'IA)

- PDF: Building Trust in AI with a Human at the Helm (Costruire la fiducia nell'IA mettendo l'uomo al timone)

- Trailhead: Gestione dei cambiamenti per l'implementazione dell'IA

- Trailhead: Einstein Trust Layer

- Articolo: AI-Powered Cyberattacks (Attacchi informatici che usano l'IA)

- Articolo: Understanding Why AI Guardrails Are Necessary: Ensuring Ethical and Responsible AI Use (Comprendere perché le misure di salvaguardia sono necessarie: assicurare un uso etico e responsabile dell'IA)

- PDF: Mitigating LLM Risks Across Salesforce’s Gen AI Frontiers (Mitigare i rischi associati agli LLM attraverso le frontiere dell'IA generativa di Salesforce)