Exploration du parcours des réponses

Objectifs de formation

Une fois cette unité terminée, vous pourrez :

- Décrire le parcours des réponses

- Expliquer ce qu’est le principe de « rétention zéro »

- Démontrer en quoi la détection du langage toxique peut être important

Trailcast

Pour écouter un enregistrement audio de ce module, utilisez le lecteur ci-dessous. Lorsque vous avez fini d’écouter cet enregistrement, n’oubliez pas de revenir à chaque unité, de consulter les ressources et de réaliser les évaluations associées.

Récapitulatif du parcours des invites

Vous pouvez déjà constater la prudence avec laquelle Salesforce a déployé la couche de confiance Einstein pour protéger les données des clients de Jessica et celles de leur entreprise. Avant d’aller plus loin, faisons un récapitulatif du parcours des répliques.

- Un modèle de réplique a été automatiquement extrait de la fonctionnalité Réponses de service pour faciliter le traitement du dossier du client de Jessica.

- Les champs de fusion du modèle de réplique ont été remplis à partir de données fiables et sécurisées, issues de l’organisation de Jessica.

- Des articles Knowledge pertinents et des informations extraites d’autres objets ont été récupérés et insérés dans la conversation pour davantage contextualiser la réplique.

- Les informations personnelles identifiables (PII) ont été masquées.

- Des garde-fous de sécurité supplémentaires ont été appliqués à la réplique pour mieux la protéger.

- La réplique est désormais prête à passer par la passerelle sécurisée avant d’être envoyée au LLM externe.

Passerelle LLM sécurisée

Maintenant que la réplique contient des données pertinentes et que des mesures de protection sont en place, elle peut sortir du Périmètre de confiance de Salesforce et passer par la passerelle LLM sécurisée avant d’atteindre les LLM connectés. Dans notre exemple, l’organisation de Jessica est connectée au LLM OpenAI. OpenAI utilise cette réplique pour générer une réponse pertinente de qualité que Jessica pourra utiliser dans sa conversation avec son client.

Rétention zéro

Si Jessica utilisait un outil LLM dédié aux consommateurs, comme un chatbot doté d’IA générative, sans une couche de confiance performante, sa réplique et toutes les données de son client, y compris la réponse du LLM, pourraient être stockées par le LLM à des fins d’entraînement. En revanche, lorsque Salesforce a pour partenaire un LLM externe optimisé par une API, nous exigeons la signature d’un accord pour garantir la sécurité de l’ensemble de l’interaction. Voilà ce qu’est notre politique de rétention zéro. En d’autres termes, aucune donnée client ni aucun texte de réplique ni aucune réponse générée n’est stocké en dehors de Salesforce.

Voici comment il fonctionne. La réplique de Jessica est envoyée à un LLM. N’oubliez pas que cette réplique est une instruction. Le LLM intègre cette réplique et génère une ou plusieurs réponses à partir des instructions de la réplique, le tout en respectant les garde-fous.

Généralement, OpenAI souhaite conserver les répliques et les réponses pendant un certain temps afin de contrôler les abus. Les LLM très puissants d’OpenAI vérifient si aucun incident n’impacte leurs modèles, comme des attaques par injection rapide (voir l’unité précédente). Cependant, notre politique de rétention zéro interdit à nos partenaires LLM de conserver les données d’interaction. Nous avons conclu un accord selon lequel nous sommes les seuls à nous charger de la modération des interactions.

Nous n’autorisons pas OpenAI à stocker des données, quelles qu’elles soient. Ainsi, lorsqu’une réplique est envoyée à OpenAI, le modèle oublie la réplique et les réponses dès que la réponse est renvoyée à Salesforce. Avec cette approche, Salesforce est autorisée à gérer son propre contenu et la modération des abus. En outre, les utilisateurs comme Jessica n’ont pas à se demander si les fournisseurs LLM vont conserver (et utiliser) ou non les données de leurs clients.

Parcours des réponses

Lorsque nous vous avons présenté Jessica, nous avons indiqué qu’elle se posait des questions sur la qualité des réponses générées par l’IA. Même si elle ne sait pas à quoi s’attendre, Jessica n’a pas à s’inquiéter, car la couche de confiance Einstein est là pour y veiller. Elle comprend plusieurs fonctionnalités conçues pour tenir une conversation à la fois professionnelle et personnalisée.

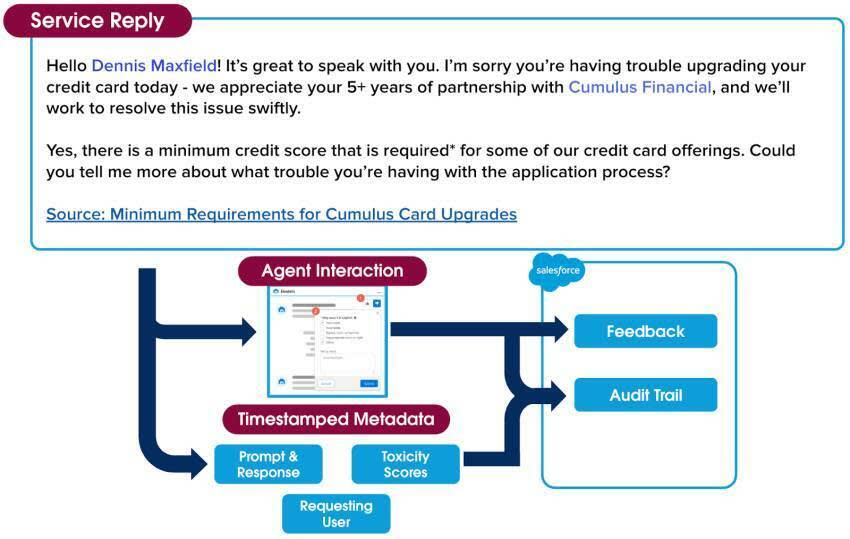

Pour l’instant, le modèle de réplique de la conversation entre Jessica et son client contient des informations client pertinentes et des éléments de contexte utiles en rapport avec l’exemple. Après avoir digéré ces informations, le LLM renvoie une réponse dans le périmètre de confiance de Salesforce. Mais Jessica ne peut pas encore la voir. Même si le ton est cordial et le contenu précis, la réponse doit d’abord être vérifiée par la couche de confiance pour éviter toute information non souhaitée. De plus, la réponse contient encore des blocs de données masqués. Jessica pourrait penser que c’est beaucoup trop impersonnel. La couche de confiance a encore quelques manipulations à effectuer avant de lui proposer sa réponse.

Hello <NAME_1>! It’s great to speak with you. I’m sorry you’re having trouble upgrading your credit card today - we appreciate your 5+ years of partnership with <COMPANY_1> and we’ll work to resolve this issue swiftly.

Yes, there is a minimum credit score that is required*for some of our credit card offerings. Could you tell me more about what trouble you’re having with the application process? (Bonjour <NAME_1> ! C’est un plaisir de vous parler. Je suis désolé que vous rencontriez des difficultés pour mettre à niveau votre carte de crédit. Nous apprécions votre partenariat de plus de 5 ans avec <COMPANY_1> et allons nous efforcer de résoudre ce problème rapidement. Oui, il existe une cote de crédit minimale requise* pour certaines de nos offres de cartes de crédit. Pourriez-vous m’en dire davantage au sujet des difficultés rencontrées avec le processus de demande ?)

Source : Exigences minimales pour les mises à niveau de carte Cumulus

Détection du langage toxique et démasquage des données

Deux opérations ont lieu lorsque la réponse à la conversation de Jessica revient dans le périmètre de confiance de Salesforce depuis le LLM. D’abord, la fonctionnalité de détection du langage toxique protège Jessica et ses clients de la toxicité. Vous vous demandez peut-être de quoi il s’agit ? La couche de confiance utilise des modèles d’apprentissage machine pour identifier et signaler le contenu toxique dans les répliques et les réponses, selon cinq catégories : contenu violent, à caractère sexuel, grossier, haineux ou menaçant. Le score de toxicité global combine les scores de toutes les catégories détectées et produit un score global compris entre 0 et 1, 1 étant le plus toxique. Le score de la réponse initiale est renvoyé en même temps que la réponse à l’application qui l’a appelé (dans notre exemple, il s’agit de la fonctionnalité Réponses de service).

Ensuite, avant que la réplique ne soit partagée avec Jessica, la couche de confiance doit révéler les données masquées dont nous avons parlé plus tôt pour proposer une réponse personnelle et adaptée au client de Jessica. La couche de confiance reprend les données tokénisées qui ont été enregistrées lorsqu’elles ont été masquées. Une fois les données démasquées, la réponse est partagée avec Jessica.

Notez également qu’il y a un lien Source en bas de la réponse. La fonctionnalité Création d’articles Knowledge renforce la crédibilité des réponses en ajoutant des liens vers des articles utiles et constructifs.

Bonjour Dennis Maxfield ! C’est un plaisir de vous parler. Je suis désolé que vous rencontriez des difficultés à mettre à niveau votre carte de crédit. Nous apprécions votre partenariat de plus de 5 ans avec Cumulus Financial et allons nous efforcer de résoudre ce problème rapidement.

Oui, il existe un score de crédit minimal requis* pour certaines de nos offres de cartes de crédit. Pourriez-vous m’en dire davantage au sujet des difficultés rencontrées avec le processus de demande ?

Source : Exigences minimales pour les mises à niveau de carte Cumulus

Infrastructure des commentaires

Lorsque Jessica voit la réponse, elle ne peut s’empêcher de sourire. Elle est impressionnée par la qualité et le niveau de détail de la réponse qu’elle a reçue du LLM. Elle est également satisfaite de la façon dont la réponse reflète son style personnel. Lorsque Jessica examine la réponse avant de l’envoyer à son client, elle constate qu’elle peut choisir de l’accepter telle quelle, de la modifier ou de l’ignorer.

Elle peut aussi (1) apporter des commentaires qualitatifs en cliquant sur le pouce levé ou le pouce baissé et, (2) si la réponse n’a pas été utile, en préciser la raison. Ce commentaire est recueilli et pourra être utilisé en toute sécurité pour améliorer la qualité des répliques.

Journal d’audit

Il nous reste un dernier élément de la couche de confiance à vous montrer. Vous vous souvenez de la politique de rétention zéro dont nous vous avons parlé au début de cette unité ? Étant donné que la couche de confiance gère en interne la notation et la modération du langage toxique, nous conservons une trace de chaque action réalisée au cours du parcours des répliques et des réponses.

Tout ce qui s’est passé au cours de l’échange entre Jessica et son client correspond à des métadonnées horodatées que nous collectons dans une piste d’audit. Sont inclues la réplique, la réponse originale non filtrée, les scores de langage toxique et les commentaires recueillis tout au long du parcours. La piste d’audit de la couche de confiance Einstein renforce la transparence du processus et permet à Jessica de s’assurer que les données de ses clients sont protégées.

Beaucoup de choses se sont passées depuis que Jessica a commencé à aider son client, mais tout s’est produit en un clin d’œil. En quelques secondes, sa conversation, initiée par la réplique d’un chat, est passée par le processus de sécurité de la couche de confiance pour générer une réponse pertinente et professionnelle qu’elle peut envoyer à son client.

Elle peut sereinement clôturer cette requête, en sachant que son client est satisfait de la réponse et de son expérience du service. Et surtout, elle pourra allègrement continuer d’utiliser la puissance de l’IA générative de la fonctionnalité Réponses de service, car elle sait qu’elle pourra clôturer ses requêtes plus rapidement, le tout en garantissant la satisfaction de ses clients.

Chacune des solutions d’IA générative Salesforce passe par la même couche de confiance. Toutes nos solutions sont sécurisées. Vous avez ainsi la garantie que vos données et celles de vos clients le sont aussi.

Félicitations ! Vous savez désormais comment fonctionne la couche de confiance Einstein. Pour en savoir plus sur ce que Salesforce fait en matière de confiance et d’IA générative, obtenez le badge Trailhead Création responsable d’intelligence artificielle.

Ressources

- Trailhead : Création responsable d’intelligence artificielle

- Aide Salesforce : Einstein GPT : IA générative de confiance