Planification de votre stratégie en matière de confiance

Objectifs de formation

Une fois cette unité terminée, vous pourrez :

- Créer un profil de risque en évaluant les risques liés à l’IA pour votre projet

- Implémenter des limites en fonction du profil de risque

Trailcast

Pour écouter un enregistrement audio de ce module, utilisez le lecteur ci-dessous. Lorsque vous avez fini d’écouter cet enregistrement, n’oubliez pas de revenir à chaque unité, de consulter les ressources et de réaliser les évaluations associées.

Premiers pas avec la stratégie de confiance

L’IA comporte certains risques. Alors, comment savoir si votre solution d’IA est éthique, sûre et responsable ? En créant une stratégie de confiance.

La stratégie de confiance de votre projet vous permet d’atténuer les risques liés à la confiance, comme la protection des données confidentielles, le respect des exigences réglementaires et la protection de la réputation de votre entreprise.

La première étape de la définition de votre stratégie de confiance consiste à créer un profil de risque pour votre projet. Un profil de risque vous informe sur la manière dont vous gérez et hiérarchisez les risques d’un projet. Il couvre le type et le niveau de risques, la probabilité des effets négatifs et le niveau de perturbation ou de coûts pour chaque type de risque. Un profil de risque efficace vous indique les risques à gérer en priorité.

Domaines de risque

Répondez à des questions relatives à trois principaux domaines de risque pour créer votre profil de risque : fuites de données, exigences réglementaires et atteinte à la réputation. À titre d’exemple, examinez les réponses de Becca à ces questions dans le cadre de son projet.

Domaine de risque |

Description |

Questions à se poser |

Réponse de Becca |

|---|---|---|---|

Fuites de données |

Les fuites de données se produisent lorsque des informations sécurisées sont accidentellement exposées. Elles peuvent être dues à des cyberattaques, à un accès non autorisé et à l’exposition de données confidentielles à des modèles d’IA externes. Pour éviter les fuites de données, stockez vos données en toute sécurité et assurez-vous que seuls les utilisateurs autorisés peuvent y accéder. Ce domaine de risque comprend également la protection des données confidentielles, telles que les informations d’identification personnelle. |

|

Becca sait que Coral Cloud dispose d’un système sécurisé de stockage de données. Cependant, son projet comprend une intervention humaine : une personne déclenche le processus d’enregistrement en demandant à Einstein d’enregistrer un client. Becca voit qu’il existe ici un risque de fuite de données, car l’utilisateur d’exécution peut savoir où le client séjourne et à quelles dates. Ces informations deviennent dangereuses si elles sont divulguées à une personne non autorisée. Le projet de Becca comprend des données confidentielles telles que des noms complets, des coordonnées et des informations de carte de crédit. |

Exigences réglementaires |

Assurez-vous que votre projet répond aux exigences légales de la juridiction et du secteur dans lesquels vous opérez. Si vous ne respectez pas toutes les réglementations, vous risquez des amendes, une atteinte à votre réputation et d’autres répercussions juridiques. L’équipe juridique que vous avez désignée dans la première unité peut vous aider à identifier et à respecter toutes les réglementations. |

|

Étant donné que Coral Cloud opère dans l’UE, le projet de Becca doit respecter le Règlement général sur la protection des données (RGPD). Becca contacte les membres de l’équipe juridique pour leur demander de rechercher les autres réglementations à respecter. |

Atteinte à la réputation |

Étant donné que votre projet d’IA interagit avec vos clients, il représente la voix de l’entreprise. L’IA peut parfois générer des réponses nuisibles ou fausses en raison de la toxicité des ensembles de données ou d’attaques techniques. |

|

Si les e-mails de bienvenue générés par l’IA contiennent un langage offensant, Coral Cloud sera considérée comme insultante et hostile. L’entreprise perdra de précieux clients actuels et potentiels. Dans le secteur de l’hôtellerie, Becca sait que l’atteinte à la réputation est un problème grave. |

Création d’un profil de risque

Sur la base de son évaluation des différents domaines de risque, Becca crée un profil de risque pour son projet. 1 représente un risque très faible, 5 représente un risque très élevé.

Type de risque |

Niveau des effets négatifs |

Probabilité des effets négatifs |

Perturbations ou coûts |

|---|---|---|---|

Fuites de données |

4 : En cas de fuite de données, la sécurité et la confidentialité des données client sont compromises. |

3 : Les données de Coral Cloud sont stockées en toute sécurité, mais d’autres contrôles doivent être mis en place pour mieux répondre à ce risque. |

4 : Perte de confiance des clients |

Exigences réglementaires |

5 : Coral Cloud risque des amendes, d’autres conséquences juridiques et la perte de confiance des clients. |

5 : Si le projet de Becca ne respecte pas la réglementation, il est très probable que Coral Cloud soit confrontée à des conséquences négatives. |

5 : Conséquences juridiques, amendes et perte de confiance des clients |

Atteinte à la réputation |

5 : Si la réputation de Coral Cloud est entachée, l’entreprise perd des clients potentiels et des bénéfices. |

4 : Becca doit peaufiner les invites et implémenter d’autres moyens pour se protéger contre toute atteinte à sa réputation. |

4 : Perte de confiance des clients |

En fonction du profil de risque, Becca décide de donner la priorité aux exigences réglementaires, puis aux atteintes à la réputation, et enfin aux fuites de données. Elle commence à planifier la gestion de chaque risque.

Types de limites

Maintenant que vous connaissez vos risques, implémentez des limites en matière d’IA. Les limites imposées à l’IA sont des mécanismes permettant de garantir que votre projet d’IA fonctionne de manière légale et éthique. Vous avez besoin de limites pour empêcher l’IA d’être nuisible en raison de décisions biaisées, d’un langage toxique et de données exposées. Des limites sont nécessaires pour protéger votre projet des attaques techniques.

Il existe trois types de limites en matière d’IA : les limites de sécurité, les limites techniques et les limites éthiques.

Limites de sécurité

Ces limites garantissent que le projet est conforme aux lois et réglementations, et que les données privées et les droits humains sont protégés. Les outils courants pour ce type de protection incluent la récupération sécurisée des données, le masquage des données et la rétention zéro des données.

La récupération sécurisée des données signifie que votre projet accède uniquement aux données auxquelles l’utilisateur d’exécution est autorisé à accéder. Par exemple, si une personne n’ayant pas accès aux enregistrements financiers déclenche une réponse du modèle d’IA, celui-ci ne doit pas récupérer de données liées aux enregistrements financiers. Le masquage des données consiste à remplacer les données confidentielles par des données d’espace réservé avant de les exposer à des modèles externes. Ainsi, les données confidentielles ne risquent pas d’être divulguées. Les fournisseurs de modèles appliquent des politiques de rétention zéro en matière de données. En d’autres termes, les données ne sont pas stockées au-delà des besoins immédiats de la tâche. Après la génération d’une réponse, les données utilisées disparaissent donc.

Limites techniques

Ces limites protègent le projet contre les attaques techniques des pirates informatiques, telles que l’injection de répliques et le débridage, ou d’autres méthodes permettant de forcer le modèle à exposer des informations confidentielles. À cause des cyberattaques, votre projet peut générer des réponses fausses ou nuisibles.

Limites éthiques

Ces limites maintiennent votre projet aligné sur les valeurs humaines. Elles permettent notamment de filtrer la toxicité et les biais.

On parle de toxicité lorsqu’un modèle d’IA génère du contenu haineux, abusif et grossier ou obscène. On parle de biais lorsque l’IA reflète des stéréotypes nuisibles, tels que des stéréotypes raciaux ou de genre. Comme vous pouvez vous en douter, il faut à tout prix les éviter ! Étant donné que l’IA apprend ses réponses, la toxicité et les biais pourraient être un signe que vos données introduisent un langage et des idées indésirables dans votre modèle. La détection de la toxicité identifie les réponses susceptibles de contenir un langage toxique, afin que vous puissiez les examiner manuellement et effectuer des ajustements pour réduire cette toxicité.

Vous savez désormais ce que sont les limites et comment elles protègent votre projet contre les risques. Découvrez maintenant comment Becca implémente des limites dans sa stratégie de confiance.

Stratégie de Coral Cloud en matière de confiance

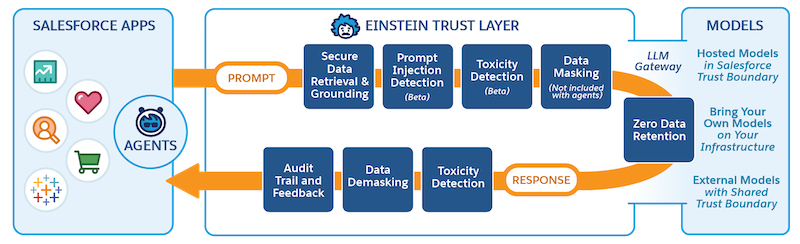

L’implémentation de votre stratégie de confiance est différente selon le système que vous utilisez. Étant donné que Becca utilise Salesforce, sa stratégie de confiance repose sur la couche de confiance Einstein. La couche de confiance est un ensemble de fonctionnalités, de processus et de politiques conçus pour protéger la confidentialité des données, améliorer la précision de l’IA et en promouvoir une utilisation responsable dans l’ensemble de l’écosystème Salesforce. Lorsque vous créez un projet avec les fonctionnalités d’IA générative Einstein, tel que le générateur d’invites dans le projet de Becca, il passe automatiquement par la couche de confiance.

Becca définit une stratégie de confiance qui aborde chaque domaine de risque, en utilisant les fonctionnalités de la couche de confiance. Elle visualise également le résultat souhaité. Voici un extrait de sa stratégie de confiance.

Domaine de risque |

Stratégie de confiance de Becca |

Fonctionnalités de la couche de confiance |

Résultat |

|---|---|---|---|

Fuites de données |

|

|

|

Atteinte à la réputation |

|

|

|

Avant que Becca ne finalise sa stratégie de confiance, elle rencontre son équipe juridique et de sécurité pour s’assurer qu’il n’y a aucune lacune.

Étapes suivantes

Avec une stratégie de confiance au point, Becca a fini de planifier son projet ! Elle est prête à commencer la phase d’élaboration, lors de laquelle elle implémentera son projet dans Salesforce. Continuez à suivre le projet de Becca dans Connexion de Data 360 à Agentforce et au générateur d’invites.

Au fur et à mesure que vous élaborez votre projet, n’oubliez pas que l’atténuation des risques n’est pas un processus ponctuel. Après avoir implémenté votre projet, surveillez et évaluez vos risques de manière continue. La surveillance vous aide à identifier rapidement les tendances problématiques et à procéder à des ajustements. Consultez les scores de toxicité et les commentaires pour identifier les problèmes dans votre solution et procédez à des ajustements pour éliminer les facteurs de risque.

Récapitulatif

Ce module explique les étapes essentielles à suivre pour préparer votre projet d’IA. Vous savez désormais comment identifier les parties prenantes d’un projet, définir des objectifs et choisir une solution technique. Vous savez comment préparer des données de haute qualité et répondre aux exigences de votre projet. Vous savez également qu’une stratégie de confiance atténue les risques pour votre projet et qu’il est important de surveiller les risques.

Grâce à vos nouvelles connaissances, vous êtes sur la bonne voie pour lancer un projet d’IA réussi ! Avant de commencer votre déploiement, assurez-vous de réaliser le module Gestion du changement et implémentation de l’IA.

Ressources

- PDF : Cadre de gestion des risques liés à l’intelligence artificielle du NIST

- Feuille de calcul Excel : Modèle d’évaluation des risques liés à l’IA du NIST

- PDF : Création d’un climat de confiance dans l’IA avec un humain à la barre

- Trailhead :Gestion du changement et implémentation de l’IA

- Trailhead : Couche de confiance Einstein

- Article : Cyberattaques s’appuyant sur l’IA

- Article : Importance des limites imposées à l’IA : garantie d’une utilisation éthique et responsable de l’IA

- PDF : Atténuation des risques liés au LLM au-delà des frontières de l’IA générative de Salesforce