Explorar las salvaguardas y los patrones de confianza de Agentforce

Objetivos de aprendizaje

Después de completar esta unidad, podrá:

- Describir las salvaguardas de la plataforma.

- Describir las salvaguardas de Agentforce.

- Explicar cómo personalizar las salvaguardas de Agentforce.

- Explicar cómo se usan los patrones de confianza para crear agentes en Salesforce.

Trailcast

Si quiere escuchar una grabación de audio de este módulo, use el reproductor a continuación. Cuando haya terminado de escuchar esta grabación, recuerde volver a cada unidad, consultar los recursos y completar las evaluaciones asociadas.

Garantizar la confianza con salvaguardas

La IA avanza rápido. Así que es normal sentir ansiedad debido a estos cambios tan rápidos. En Salesforce, nuestro equipo de productos y la Oficina de uso ético y humano (OEHU) reconocen que mantener la confianza en nuestros productos es crucial y abordan los riesgos y las inquietudes relacionadas con la IA de agentes mediante:

- La identificación de los controles necesarios para crear un agente de confianza

- La creación de una estrategia de pruebas

- La incorporación de salvaguardas éticas para los productos

- La propuesta de mejores directrices éticas a nuestros clientes

Crear estas salvaguardas para nuestros productos y brindar directrices éticas claras ayudan a que las compañías manejen la tecnología de IA con responsabilidad al tiempo que mantienen la seguridad y confianza de todos.

Para analizar detenidamente algunos detalles, empecemos con las salvaguardas de la plataforma, que brindan controles globales para todos nuestros productos.

Salvaguardas de la plataforma

Salesforce incluye un conjunto de políticas, directrices y protocolos integrales diseñados para garantizar las operaciones éticas y seguras, y que cumplen con las normativas de la plataforma. Algunas de estas salvaguardas son:

-

Política de uso aceptable (AUP): reglas generales para el uso de los servicios de Salesforce por parte de los clientes, que prohíben las actividades que podrían perjudicar a la plataforma o a sus usuarios.

-

Política de uso aceptable de la IA (AI AUP): reglas específicas para el uso de las tecnologías de IA de Salesforce por parte de los clientes, que garantiza que nuestros productos se usen de forma responsable.

-

Políticas de contención de modelos: reglas claras sobre cómo se usan los modelos de IA. Estas reglas garantizan que los modelos de IA se usen respetando determinados límites para evitar que se usen de forma incorrecta o tengan efectos imprevistos.

Estos controles crean un marco de trabajo que mantiene los estándares de integridad, seguridad y ética de la plataforma. Por ejemplo, según la AUP, no se puede usar la plataforma para hacer spam ni phishing. Según la AUP de IA, la IA no puede tomar decisiones legales o importantes sin la aprobación final de un humano. Las políticas de contención de modelos pueden limitar los tipos de datos a los que puede acceder un modelo de IA para evitar la fuga de datos o el uso inadecuado.

Salvaguardas de Agentforce

Las salvaguardas de Agentforce son un conjunto de reglas, directrices y mejores prácticas realizadas para Salesforce Cloud o para productos o usos comerciales específicos de Salesforce con el fin de garantizar que los agentes sigan los estándares y las leyes locales. Agentforce incluye salvaguardas de ética para disminuir las alucinaciones de la IA y salvaguardas de seguridad para prevenir amenazas y ataques maliciosos, como inyecciones de solicitudes.

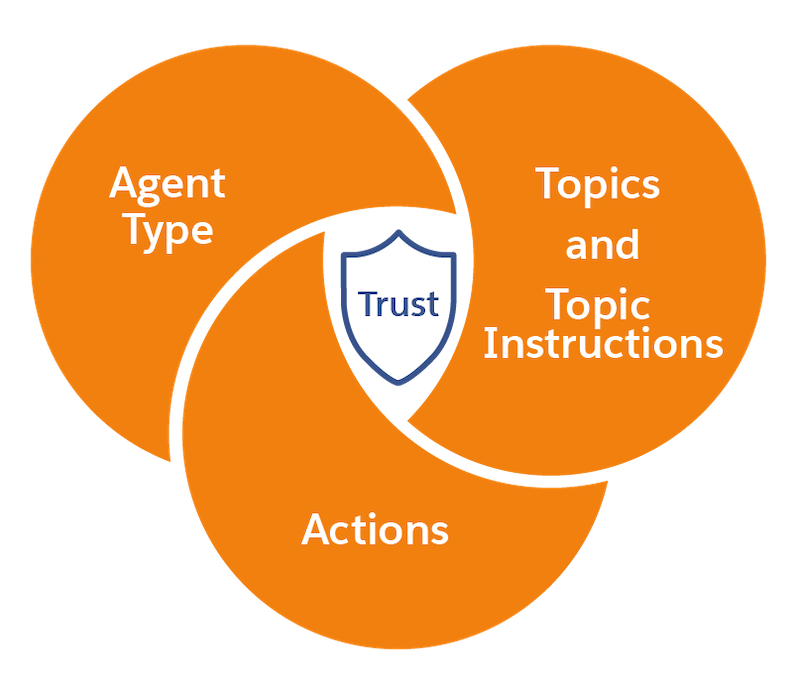

Tipo de agente

Salesforce ofrece agentes listos para usar para nubes específicas y casos de uso comunes. Los distintos tipos de agentes pueden tener sus propios parámetros de configuración y salvaguardas para definir el comportamiento del agente. Por ejemplo, el Agente de servicio de Agentforce (ASA) usa instrucciones de tema para determinar cuándo se deriva la plática del agente de IA a un representante humano. El Representante de desarrollo de ventas (SDR) cuenta con reglas de implicación definidas por el administrador para determinar las condiciones que se tienen que dar para que el agente empiece a trabajar en el prospecto, y cómo y cuándo los agentes pueden enviar emails.

Temas, instrucciones de temas y acciones

Todos los agentes contienen un conjunto de temas y acciones prediseñados.

Los temas son la categoría de acciones relacionadas con un trabajo en particular que los agentes deben hacer. Los temas contienen acciones, que son las herramientas disponibles para el trabajo, e instrucciones, que le indican al agente cómo tomar decisiones. En conjunto, los temas definen la variedad de capacidades que su agente puede manejar. Salesforce ofrece una biblioteca de temas estándares para casos de uso comunes.

Las instrucciones del tema establecen las directrices para el comportamiento del agente y proporcionan el contexto necesario para trabajar de forma eficiente. Cada tema es una categoría de acciones relacionadas con un trabajo específico que contiene acciones (herramientas) e instrucciones (directrices de toma de decisiones). Las instrucciones ayudan a los agentes a tomar decisiones sobre cómo usar las acciones en un tema para los distintos casos de uso. Estas instrucciones suelen estar formuladas como “Siempre...”, “Nunca...”, “Si sucede X, haz Y...” o “Como primer paso...” para garantizar un comportamiento claro y coherente.

Las acciones son la forma en que los agentes logran hacer las tareas. Los agentes incluyen una biblioteca de acciones, que es un conjunto de los trabajos pueden realizar. Por ejemplo, si un usuario le pide ayuda al agente para escribir un email, el agente inicia una acción que elabora un borrador, revisa el email y lo fundamenta con los datos de Salesforce pertinentes. Salesforce ofrece algunas acciones listas para usar, y estas acciones se denominan acciones estándares. La ventaja de incluir temas y acciones estándares de forma predeterminada es que su agente está preparado para ayudar a los usuarios con muchas tareas comunes al instante.

Personalizar las salvaguardas

Para tener un control más preciso, use las instrucciones de temas de agente para crear límites, establecer contextos y definir el comportamiento de los agentes. Puede modificar las instrucciones para un tema de agente estándar, o crear un tema personalizado desde cero.

Su administrador controla estas salvaguardas y, en general, su líder interno o la persona responsable de la toma de decisiones se encarga de la aprobación final. Esto garantiza que las directrices sean oficiales y reflejen los requisitos de cumplimiento y valores de su organización.

Capa de confianza de Einstein

Los agentes de IA se integran en la Capa de Confianza de Einstein, que es una arquitectura de IA segura incorporada de forma nativa en Salesforce.

Diseñada para satisfacer estándares de seguridad empresarial, la Capa de confianza le permite aprovechar los beneficios de la IA generativa sin comprometer los datos de sus clientes. También permite utilizar datos confiables para mejorar las respuestas de la IA generativa.

-

Fundamentación de datos: La Capa de confianza garantiza que las solicitudes generativas estén fundamentadas y enriquecidas con los datos de confianza de la compañía.

-

Retención de datos cero: sus datos nunca serán retenidos por un proveedor de un LLM externo.

-

Detección de toxicidad: las respuestas del LLM posiblemente dañinas se detectan y marcan.

-

Monitoreo de la IA: las interacciones de la IA se capturan en registros de eventos, lo que le brinda visibilidad de los resultados de cada interacción del usuario.

Patrones de confianza de los agentes

En nuestros productos, implementamos varios patrones de confianza clave y diseños de productos estándares para mejorar la seguridad. A continuación se muestran algunos ejemplos.

Patrón de confianza |

Ejemplo |

|---|---|

Reducir alucinaciones. |

Usamos la clasificación de temas para asignar entradas de usuarios a temas específicos. Esto disminuye el riesgo de que un agente genere información incorrecta o irrelevante. |

Limitar la frecuencia de los emails generados por un agente. |

Limitamos la frecuencia de los emails generados por un agente para no abrumar a los usuarios y garantizar que la comunicación sea valiosa. |

Respetar la privacidad de los usuarios. |

Incluimos una función de exclusión en el software de CRM para que los usuarios controlen con qué frecuencia reciben comunicación de los agentes de IA. |

Crear transparencia por diseño. |

Nos aseguramos de que haya constancia directa y transparente de que el contenido se generó con IA. |

Facilitar la derivación de IA a humanos. |

Facilitamos la transición para pasar de los agentes a los humanos sin dificultad. Algunos ejemplos incluyen copiar a un gerente de ventas en los emails generados por IA o proporcionar un tablero para la supervisión humana. |

Implementación de mejores prácticas

Cuando implementa las salvaguardas de Agentforce en su organización, siga estas mejores prácticas.

Mejor práctica |

Ejemplo |

|---|---|

Entender las políticas. |

Cree una lista de las políticas que se pueden aplicar a su sector, área geográfica y caso de uso. Utilícela para delimitar qué puede hacer el agente y qué no. Esto puede ayudar a determinar los temas que se pueden asignar a su agente. |

Implementar medidas de seguridad sólidas. |

Limite el acceso de los agentes a lo que necesitan para completar las tareas asignadas. Asegúrese de que los agentes cumplan con los requisitos reglamentarios y de protección de datos. Utilice las instrucciones de tema para establecer las reglas que el agente debe respetar. |

Facilitar la supervisión humana. |

Establezca directrices claras sobre cómo y cuándo derivar a representantes humanos. Utilice las instrucciones de tema para establecer estas directrices. |

Supervisar y auditar. |

Además de las pruebas iniciales, la supervisión continua ayuda a garantizar que el rendimiento de los agentes respete su diseño. Utilice la función de Traza de auditoría en la Capa de confianza de Einstein para obtener información detallada sobre las acciones y los resultados de la IA. |

Respetar la privacidad de los usuarios. |

Utilice la función de exclusión para permitir que los usuarios controlen la frecuencia de comunicación y protejan su privacidad. |

Dirigir evaluaciones regulares. |

Dirija evaluaciones de sesgos, capacidad de explicación y solidez con regularidad para supervisar la seguridad y confianza constantes. |