Seguir el recorrido de la respuesta

Objetivos de aprendizaje

Después de completar esta unidad, podrá:

- Describir el recorrido de la respuesta.

- Explicar la retención cero de datos.

- Debatir por qué es importante la detección de lenguaje tóxico.

Trailcast

Si quiere escuchar una grabación de audio de este módulo, use el reproductor a continuación. Cuando haya terminado de escuchar esta grabación, recuerde volver a cada unidad, consultar los recursos y completar las evaluaciones asociadas.

Breve repaso del recorrido de la solicitud

Ya puede ver las medidas cuidadosas que toma Salesforce con la Capa de confianza de Einstein para proteger los datos de los clientes de Jessica y de su compañía. Antes de continuar con su aprendizaje, haga un repaso rápido del recorrido de la solicitud.

- Respuestas de servicio extrajo automáticamente una plantilla de solicitud para brindar asistencia al caso de servicio de atención al cliente de Jessica.

- Los campos de combinación de la plantilla de solicitud se completaron con datos seguros y confiables de la organización de Jessica.

- Para agregar contexto a la solicitud, se recuperaron e incluyeron artículos de Knowledge relevantes y detalles de otros objetos.

- Se enmascaró la información de identificación personal (PII).

- Para mayor protección, se agregaron mensajes de seguridad adicionales a la solicitud.

- En este punto, la solicitud está lista para pasar a través de la puerta de enlace segura al LLM externo.

Puerta de enlace de LLM segura

Una vez que se completa con los datos relevantes y las protecciones establecidas, la solicitud está lista para salir del Límite de confianza de Salesforce a través de la puerta de enlace de LLM segura hacia los LLM conectados. En este caso, el LLM al que está conectada la organización de Jessica es OpenAI. OpenAI utiliza esta solicitud para generar una respuesta relevante y de alta calidad que Jessica puede utilizar en su plática con el cliente.

Retención cero de datos

Si Jessica utilizara una herramienta de LLM orientada al consumidor, como un chatbot de IA generativa, sin una capa de confianza sólida, su solicitud, incluidos todos los datos del cliente e incluso la respuesta del LLM, podrían almacenarse en el LLM para el entrenamiento del modelo. Sin embargo, cuando Salesforce se asocia con un LLM externo basado en API, exigimos un acuerdo para proteger toda la interacción, lo que se denomina retención cero de datos. Nuestra política de retención cero de datos implica que ningún dato del cliente, incluidos el texto de la solicitud y las respuestas generadas, se almacenan fuera de Salesforce.

Así es como funciona. La solicitud de Jessica se envía a un LLM. Recuerde que se trata de una instrucción. El LLM toma esa solicitud y, en función de las instrucciones y sin sobrepasar los límites de seguridad, genera una o varias respuestas.

Por lo general, OpenAI desea conservar las solicitudes y las respuestas durante un periodo de tiempo para controlar el mal uso. Gracias a su increíble solidez, los LLM de OpenAI comprueban si sucede algo inusual en sus modelos, como los ataques de inyección de solicitud sobre los que aprendió en la unidad anterior. Sin embargo, nuestra política de retención cero de datos impide que los socios de LLM conserven datos de la interacción. Llegamos al acuerdo de que nosotros nos encargamos de esa moderación.

No permitimos que OpenAI almacene nada. De este modo, cuando se envía una solicitud a OpenAI, el modelo olvida la solicitud y las respuestas una vez que la respuesta se envía de vuelta a Salesforce. Esto es importante porque permite que Salesforce gestione su propio contenido y ayude a moderar el mal uso. Además, los usuarios como Jessica no tienen que preocuparse por el almacenamiento y uso de los datos de sus clientes por parte de los proveedores de LLM.

El recorrido de la respuesta

Cuando presentamos a Jessica por primera vez, mencionamos que le preocupaba un poco que las respuestas que genere la IA no se adapten a su nivel de escrupulosidad. No está muy segura de lo que le espera, pero no tiene que preocuparse porque la Capa de confianza de Einstein se encarga de todo. Contiene varias funciones que ayudan a mantener una plática personalizada y profesional.

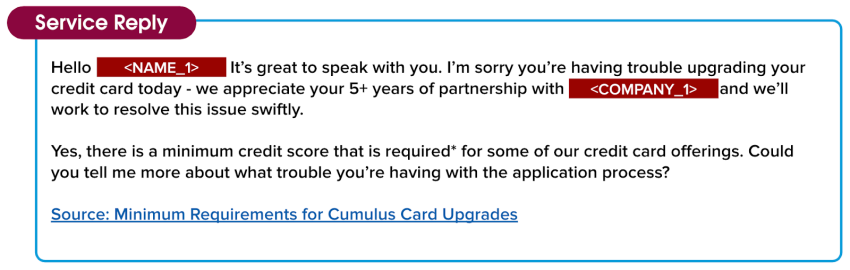

Hasta ahora, vimos la plantilla de solicitud de la plática de Jessica con su cliente completada con información relevante del cliente y contexto útil relacionado con el caso. El LLM procesó estos datos y envió una respuesta al Límite de confianza de Salesforce. Pero aún no está lista para que Jessica la vea. La Capa de confianza debe comprobar que no se produzcan resultados no deseados, aunque el tono sea amable y el contenido, exacto. La respuesta aún contiene bloques de datos enmascarados, y Jessica la considera demasiado impersonal para enviarla a su cliente. Antes de que ella vea la respuesta, la Capa de confianza tiene que realizar algunas acciones importantes.

Hola, <NAME_1>: Es un placer platicar con usted. Lamentamos que tenga problemas para actualizar su tarjeta de crédito hoy. Apreciamos sus más de 5 años de asociación con <COMPANY_1> y trabajaremos para resolver este problema con rapidez.

Sí, algunas de nuestras ofertas de tarjetas de crédito requieren* una puntuación de crédito mínima. ¿Podría contarme más sobre los problemas que tiene con el proceso de solicitud?

Fuente: Requisitos mínimos para la actualización de la tarjeta Cumulus

Detección de lenguaje tóxico y desenmascaramiento de datos

Cuando la respuesta a la plática de Jessica pasa del LLM al Límite de confianza de Salesforce, ocurren dos cosas importantes. En primer lugar, la detección de lenguaje tóxico protege a Jessica y a sus clientes de la toxicidad. Se preguntará en qué consiste este proceso. La Capa de confianza utiliza modelos de aprendizaje automático para identificar y marcar contenido tóxico en avisos y respuestas, en cinco categorías: violencia, sexual, blasfemias, odio y físico. La puntuación de toxicidad general combina las puntuaciones de todas las categorías detectadas y produce una puntuación general que va de 0 a 1, con 1 como la más tóxica. se devuelve la puntuación de la respuesta inicial junto con la respuesta a la aplicación que la solicitó, en este caso, Respuestas de servicio.

A continuación, antes de que la solicitud llegue a Jessica, la Capa de confianza debe revelar los datos enmascarados de los que hablamos antes para que la respuesta sea personal y adecuada para el cliente de Jessica. La Capa de confianza utiliza los mismos datos tokenizados que guardamos cuando enmascaramos los datos originalmente para desenmascararlos. Una vez desenmascarados los datos, la respuesta se comparte con Jessica.

Observe también que hay un vínculo a la fuente al final de la respuesta. La herramienta de creación de artículos de Knowledge aporta credibilidad a las respuestas al incluir vínculos a artículos de fuentes útiles.

Hola, Dennis Maxfield: Es un placer platicar con usted. Lamentamos que tenga problemas para actualizar su tarjeta de crédito; apreciamos sus más de 5 años de asociación con Cumulus Financial y trabajaremos para resolver este problema rápidamente.

Sí, algunas de nuestras ofertas de tarjetas de crédito requieren* una puntuación de crédito mínima. ¿Podría contarme más sobre los problemas que tiene con el proceso de solicitud?

Fuente: Requisitos mínimos para la actualización de la tarjeta Cumulus

Marco de comentarios

Al ver la respuesta por primera vez, Jessica sonríe. Le sorprende la calidad y el nivel de detalle de la respuesta que recibió del LLM. También está satisfecha porque se adapta bien a su estilo personal de gestión de casos. Cuando Jessica revisa la respuesta antes de enviarla a su cliente, ve que puede elegir entre aceptarla, modificarla antes de enviarla o desestimarla.

También puede (1) hacer una evaluación cualitativa en forma de pulgar hacia arriba o pulgar hacia abajo, y (2) si la respuesta no fue útil, especificar el motivo. Estos comentarios se guardan y se pueden utilizar para mejorar la calidad de las solicitudes de manera segura en el futuro.

Traza de auditoría

Hay una última característica de la Capa de confianza que debe conocer. ¿Recuerda la política de retención cero de datos de la que hablamos al principio de esta unidad? Dado que la Capa de confianza gestiona de manera interna la puntuación y la moderación del lenguaje tóxico, hacemos un seguimiento de todo lo que sucede a lo largo del recorrido entre la solicitud y la respuesta.

Todo lo que ocurrió durante la interacción entre Jessica y su cliente son metadatos con marca de tiempo que recopilamos en una traza de auditoría. Esto incluye la solicitud, la respuesta original sin filtrar, la puntuación de lenguaje tóxico y los comentarios recopilados a lo largo del proceso. La traza de auditoría de la Capa de confianza de Einstein agrega una capa de responsabilidad, por lo que Jessica puede estar segura de que los datos de sus clientes están protegidos.

Pasaron muchas cosas desde que Jessica empezó a ayudar a su cliente, pero todo sucedió en un abrir y cerrar de ojos. En cuestión de segundos, su plática pasó de una solicitud generada mediante el chat, a través de la seguridad de todo el proceso de la Capa de confianza, a una respuesta relevante y profesional que puede enviar a un cliente.

Cuando cierra el caso, sabe que a su cliente le satisfacen la respuesta y la experiencia del servicio de atención al cliente que obtuvo. Lo mejor de todo es que desea seguir utilizando la potencia de la IA generativa de Respuestas de servicio porque sabe con certeza que la ayudará a cerrar casos más rápidamente y a satisfacer a sus clientes

Todas las soluciones de IA generativa de Salesforce pasan por el mismo proceso de la Capa de confianza. Son soluciones seguras, por lo que puede confiar en que sus datos y los de sus clientes están protegidos.

Felicitaciones, acaba de aprender cómo funciona la Capa de confianza de Einstein. Para obtener más información sobre lo que hace Salesforce en torno a la confianza y la IA generativa, obtenga la insignia de Trailhead Creación responsable de inteligencia artificial.

Recursos

- Trailhead: Creación responsable de inteligencia artificial

- Ayuda de Salesforce: Einstein GPT: IA generativa de confianza