Nutzung von großen Sprachmodellen in Salesforce

Lernziele

Nachdem Sie diese Lektion abgeschlossen haben, sind Sie in der Lage, die folgenden Aufgaben auszuführen:

- Erläutern, wie Salesforce den Aspekt "Vertrauen" bei der Verwendung von LLMs sicherstellt

- Auswählen der richtigen LLM-Option für Ihr Unternehmen

- Beschreiben der Beschränkungen der verfügbaren LLM-Optionen

Vertrauen als wichtige Priorität

Vertrauen ist unser wichtigster Grundwert bei Salesforce. Es ist daher nur logisch, dass Salesforce Sicherheit und Vertrauen auch bei der Verwendung großer Sprachmodelle (LLMs) fordert. Und der Schlüssel zur Aufrechterhaltung dieses Vertrauens besteht in der Einstein-Vertrauensebene. Die Einstein-Vertrauensebene stellt die Sicherheit von generativer AI mittels Daten- und Datenschutzkontrollen sicher, die nahtlos in die Salesforce-Endbenutzererfahrung integriert sind. Durch diese Kontrollen kann Einstein AI bereitstellen, die abruferweiterte Generierung (Retrieval-Augmented Generation =RAG) auf sichere Weise verwendet, um Ihre Kunden- und Unternehmensdaten zur Kontextbildung zu nutzen, ohne potenzielle Sicherheitsrisiken zu schaffen. In ihrer einfachsten Form umfasst die Einstein-Vertrauensebene eine Reihe von Gateways und Abrufmechanismen, die zusammen eine vertrauenswürdige und offene generative AI ermöglichen.

Vertrauenswürdige Salesforce-Agenten

Agentforce-Agenten verwenden führende LLMs über die Einstein-Vertrauensebene, indem sie mithilfe von RAG sichere Aufforderungen mit Salesforce- und Data Cloud-Daten erstellen. Dies schafft eine umfangreiche, sichere Umgebung für die Verwendung von AI-Agenten, die Mitarbeiter und Kunden unterstützen kann. Diese Agenten bieten nicht nur Vorschläge, sondern können völlig unabhängig Aufgaben erledigen. Sie können beispielsweise ganz ohne menschliches Eingreifen Kundenanfragen beantworten, Probleme beheben und sogar Verkaufsempfehlungen abgeben. Bei all diesen Aktivitäten nutzen Agenten die Vertrauensebene, um Daten zu schützen und zuverlässige Antworten zu liefern.

Auswahl des besten LLMs

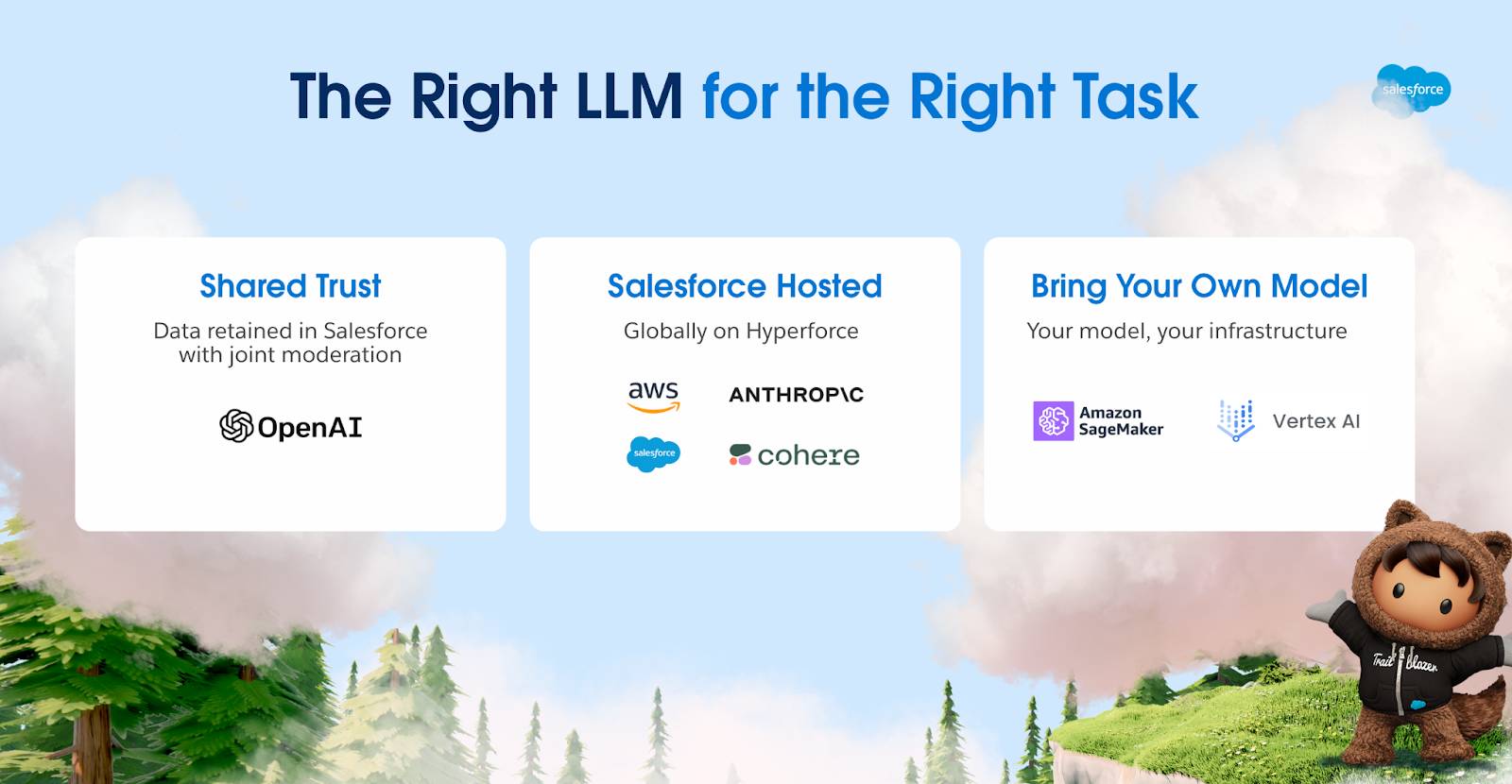

Die Wahl des richtigen Modells für die richtige Aufgabe hilft Ihnen, generative KI schneller einsetzen zu können. Salesforce bietet Bereitstellungsmöglichkeiten für jedes relevante LLM und unterstützt Unternehmen gleichzeitig dabei, ihre Datenschutz-, Sicherheits-, Residenz- und Compliance-Ziele einzuhalten.

Viele LLMs müssen eventuell abhängig von den Anwendungsfällen genutzt werden. Kunden möchten LLMs wahrscheinlich unterschiedlich einsetzen, weil sie unterschiedliche Anforderungen hinsichtlich der Datenresidenz haben.

Verwenden von Salesforce freigegebener LLMs

Von Salesforce freigegebene LLMs stellen eine Möglichkeit dar, über das Internet auf LLMs zuzugreifen. Salesforce und sein Partner OpenAI haben mit dieser Entwicklung Pionierarbeit geleistet. Salesforce nutzt ein sicheres Gateway, um Aufforderungen zur Beantwortung über das Internet an seine hervorragenden LLMs zu schicken.

Mit Einstein können Kunden von Salesforce AI Research entwickelte Salesforce-LLMs zur Unterstützung fortschrittlicher Funktionen wie die Codegenerierung und Anleitung bei der Geschäftsprozessautomatisierung nutzen und damit die Art und Weise, wie Unternehmen mit ihrer CRM-Software interagieren, grundlegend verändern. Salesforce-LLMs, einschließlich CodeGen, CodeT5+ und CodeTF, helfen Unternehmen, die Produktivität zu steigern, die Talentlücke zu schließen, die Implementierungskosten zu senken und Vorfälle besser zu erkennen.

Verwenden von Salesforce gehosteter Drittanbieter-LLMs

Sie können Modelle auch innerhalb von Salesforce hosten.

Im Zuge des Engagements von Salesforce für ein offenes Ökosystem ist Einstein so konzipiert, dass LLMs von Amazon, Anthropic, Cohere und anderen gehostet werden können – und zwar komplett innerhalb der Salesforce-Infrastruktur. Einstein wird dabei helfen, Kundenaufforderungen und -antworten in der Salesforce-Infrastruktur zu verwalten. Darüber hinaus haben Salesforce und OpenAI eine gemeinsame Vertrauenspartnerschaft zur Bereitstellung von Inhalten über die Einstein-Vertrauensebene geschlossen.

Bring Your Own Model (BYOM)

Wenn Sie bereits in Ihr eigenes Modell investieren, ist für Sie wahrscheinlich die Option zur Nutzung des eigenen Modells "Bring Your Own Model" (BYOM) sinnvoll.

Sie profitieren von Einstein auch dann, wenn Sie Ihre eigenen domänenspezifischen Modelle außerhalb von Salesforce trainiert haben und die Daten in Ihrer eigenen Infrastruktur speichern. Diese Modelle, ob sie nun über Amazon SageMaker oder Google Vertex AI laufen, werden über die Einstein-Vertrauensebene direkt mit Einstein verbunden. In diesem Szenario bleiben Kundendaten innerhalb der Vertrauensgrenzen des Kunden.

Die BYOM-Optionen ändern sich rasant! Prüfen Sie regelmäßig, ob es neue Aktualisierungen für die Ressourcen gibt.

Ressourcen

- Trailhead: Die Einstein-Vertrauensebene

- Trailhead: Maskieren der Daten für große Sprachmodelle mit der Einstein-Vertrauensebene

- Trailhead: Abruferweiterte Generierung: Schnelleinstieg

- Salesforce-Hilfe: Die Einstein-Vertrauensebene: Konzipiert für Vertrauen

- Salesforce-Hilfe: Bring Your Own Model (BYOM)

- Trailhead: Vorbereiten Ihrer Daten für KI

- Salesforce News & Insights: Salesforce kündigt KI-Cloud an und bietet Unternehmen damit vertrauenswürdige generative KI (auf Englisch)

- Trailhead: Erste Schritte mit künstlicher Intelligenz

- Salesforce The 360 Blog: 4 Möglichkeiten, mit großen Sprachmodellen mehr aus Kundendaten zu machen (auf Englisch)

- Hilfe zu Salesforce Data Cloud: Bring Your Own Model (BYOM)

- Salesforce News & Insights:: Salesforce führt BYOM ein, um Unternehmen die Verwendung proprietärer Daten zur Erstellung und Bereitstellung von KI-Modellen zu erleichtern (auf Englisch)

- Blog für Entwickler: Verwenden eigener KI-Modelle mit Data Cloud (auf Englisch)