Planen Ihrer Vertrauensstrategie

Lernziele

Nachdem Sie diese Lektion abgeschlossen haben, sind Sie in der Lage, die folgenden Aufgaben auszuführen:

- Erstellen eines Risikoprofils durch Bewerten der AI-Risiken Ihres Projekts

- Implementieren von Leitplanken auf Grundlage des Risikoprofils

Trailcast

Wenn Sie sich eine Audioaufzeichnung dieses Moduls anhören möchten, nutzen Sie den nachstehenden Player. Denken Sie nach dem Anhören dieser Aufzeichnung daran, zur jeweiligen Lektion zurückzukehren, sich die Ressourcen anzusehen und die zugehörigen Aufgaben zu absolvieren.

Erste Schritte mit Trust

AI birgt gewisse Risiken. Wie können Sie also sichergehen, dass Ihre AI-Lösung ethisch, sicher und verantwortungsvoll ist? Indem Sie eine Vertrauensstrategie entwickeln.

Die Vertrauensstrategie Ihres Projekts ist Ihr Plan zur Minderung von Vertrauensrisiken, indem Sie beispielsweise sensible Daten sichern, gesetzliche Vorschriften einhalten und den Ruf Ihres Unternehmens schützen.

Der erste Schritt bei der Festlegung Ihrer Vertrauensstrategie besteht darin, ein Risikoprofil für Ihr Projekt zu erstellen. Ein Risikoprofil enthält Angaben dazu, wie Sie die Risiken eines Projekts managen und priorisieren. Es beinhaltet die Art und den Schweregrad von Risiken, die Wahrscheinlichkeit negativer Auswirkungen und das Ausmaß von Störungen oder Kosten für jede Art von Risiko. Ein effektives Risikoprofil zeigt Ihnen, welche Risiken Sie priorisieren sollten.

Risikobereiche

Beantworten Sie Fragen zu drei Hauptrisikobereichen, um Ihr Risikoprofil zu erstellen: Datenlecks, gesetzliche Anforderungen und Rufschädigung. Sehen Sie sich als Beispiel an, wie Becca diese Fragen für ihr Projekt beantwortet.

Risikobereich |

Beschreibung |

Zu stellende Fragen |

Beccas Antwort |

|---|---|---|---|

Datenlecks |

Datenlecks liegen vor, wenn sichere Informationen versehentlich preisgegeben werden. Dies kann durch Cyberangriffe, unbefugten Zugriff und die Offenlegung sensibler Daten für externe AI-Modelle geschehen. Um Datenlecks zu verhindern, sollten Sie Ihre Daten sicher speichern und sicherstellen, dass nur autorisierte Benutzer darauf zugreifen können. Zu diesem Risikobereich gehört auch der Schutz sensibler Daten, wie z. B. personenbezogener Informationen. |

|

Becca weiß, dass Coral Cloud über ein sicheres System zur Datenspeicherung verfügt. Ihr Projekt beinhaltet jedoch einen Human-in-the-Loop, also eine menschliche Interaktion, bei der jemand den Check-in-Prozess auslöst, indem er Einstein mitteilt, dass ein Gast eingecheckt werden soll. Becca sieht hier die Gefahr von Datenlecks, da der ausführende Benutzer feststellen kann, wo sich der Gast aufhält und an welchen Terminen. Das sind gefährliche Informationen, wenn sie an Unbefugte weitergegeben werden. Beccas Projekt umfasst sensible Daten wie vollständige Namen, Kontaktinformationen und Kreditkartendaten. |

Gesetzliche Anforderungen |

Vergewissern Sie sich, dass Ihr Projekt die gesetzlichen Anforderungen des Landes und der Branche einhält, in der Sie tätig sind. Wenn Sie nicht alle Vorschriften einhalten, könnten Geldstrafen, Rufschädigung und andere rechtliche Konsequenzen drohen. Das Rechtsteam, das Sie in der ersten Lektion ermittelt haben, kann Ihnen helfen, alle Vorschriften festzustellen und einzuhalten. |

|

Da Coral Cloud in der EU tätig ist, muss Beccas Projekt die Datenschutz-Grundverordnung (DSDVO) einhalten. Becca bittet das Rechtsteam zu prüfen, welche sonstigen Vorschriften sie beachten muss. |

Rufschädigung |

Da Ihr AI-Projekt mit Ihren Kunden interagiert, repräsentiert es das Unternehmen. AI kann aufgrund von toxischen Datensätzen oder technischen Angriffen manchmal schädliche oder unwahre Antworten generieren. |

|

Wenn die AI-generierten Willkommens-E-Mails beleidigende Formulierungen enthalten, wird Coral Cloud als beleidigend und unfreundlich wahrgenommen. Das Unternehmen wird dadurch wertvolle Bestandskunden und potenzielle Kunden verlieren. Becca ist sich dessen bewusst, dass der Reputationsverlust im Gastgewerbe ein schwerwiegendes Problem ist. |

Erstellen eines Risikoprofils

Auf der Grundlage ihrer Bewertung der verschiedenen Risikobereiche erstellt Becca ein Risikoprofil für ihr Projekt. 1 steht für ein sehr geringes Risiko, 5 steht für ein sehr hohes Risiko.

Art von Risiko |

Schweregrad negativer Auswirkungen |

Wahrscheinlichkeit negativer Auswirkungen |

Störungen oder Kosten |

|---|---|---|---|

Datenlecks |

4: Datenlecks gefährden die Sicherheit des Gäste und den Schutz ihrer Daten. |

3: Die Daten von Coral Cloud sind sicher gespeichert, es sollten jedoch weitere Kontrollen eingeführt werden, um dieses Risiko zu verringern. |

4: Verlust von Kundenvertrauen |

Gesetzliche Anforderungen |

5: Coral Cloud drohen Geldstrafen, andere rechtliche Konsequenzen und der Verlust von Kundenvertrauen. |

5: Wenn Beccas Projekt die Vorschriften nicht erfüllt, sind negative Konsequenzen für Coral Cloud sehr wahrscheinlich. |

5: Rechtliche Konsequenzen, Geldstrafen und Verlust von Kundenvertrauen |

Rufschädigung |

5: Wird der Ruf von Coral Cloud geschädigt, verliert das Unternehmen potenzielle Gäste und Einnahmen. |

4: Becca muss ihre Aufforderung optimieren und andere Maßnahmen zum Schutz vor Rufschädigung implementieren. |

4: Verlust von Kundenvertrauen |

Auf der Grundlage des Risikoprofils beschließt Becca, den gesetzlichen Anforderungen Priorität einzuräumen, gefolgt von Rufschädigung und Datenlecks. Sie beginnt zu planen, wie die einzelnen Risiken gemanagt werden sollen.

Arten von Leitplanken

Nachdem Sie nun Ihre Risiken kennen, sollten Sie AI-Leitplanken implementieren. AI-Leitplanken sind Mechanismen, die sicherstellen, dass Ihr AI-Projekt rechtlich und ethisch einwandfrei arbeitet. Sie brauchen Leitplanken, um zu verhindern, dass AI durch verzerrte Entscheidungen, toxische Sprache und offengelegte Daten Schaden anrichtet. Leitplanken sind notwendig, um Ihr Projekt vor technischen Angriffen zu schützen.

Es gibt drei Arten von AI-Leitplanken: Sicherheitsleitplanken, technische Leitplanken und ethische Leitplanken.

Sicherheitsleitplanken

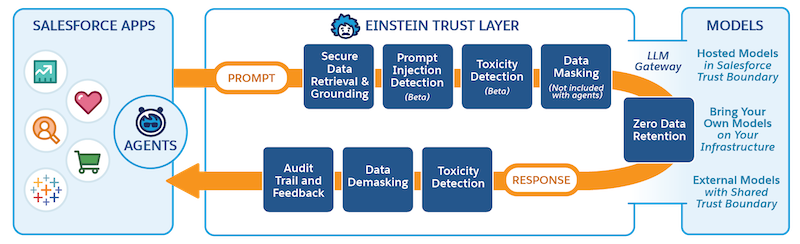

Diese Leitplanken stellen sicher, dass das Projekt Gesetze und Vorschriften einhält sowie private Daten und Menschenrechte geschützt werden. Zu den gängigen Tools dafür gehören der sichere Datenabruf, die Datenmaskierung und die Null-Datenspeicherung.

Sicherer Datenabruf bedeutet, dass Ihr Projekt nur auf Daten zugreift, für die der ausführende Benutzer eine Zugriffsberechtigung hat. Wenn z. B. eine Person, die keinen Zugriff auf Finanzdatensätze hat, eine Reaktion des AI-Modells auslöst, sollte das Modell keine Daten im Zusammenhang mit Finanzdatensätzen abrufen. Datenmaskierung bedeutet, dass sensible Daten durch Platzhalterdaten ersetzt werden, bevor sie für externe Modelle zugänglich gemacht werden. Auf diese Weise wird sichergestellt, dass sensible Daten nicht durch Datenlecks offengelegt werden. Modellanbieter setzen Null-Datenaufbewahrungsrichtlinien um, was bedeutet, dass Daten nicht länger gespeichert werden als sie unmittelbar für die vorliegende Aufgabe benötigt werden. Sobald eine Antwort generiert wurde, verschwinden die verwendeten Daten also.

Technische Leitplanken

Diese Leitplanken schützen das Projekt vor technischen Angriffen durch Hacker, wie z. B. Prompt Injection und Jailbreaking, oder vor anderen Methoden, die das Modell zur Offenlegung sensibler Informationen zwingen. Cyberangriffe können dazu führen, dass Ihr Projekt unwahre oder schädliche Antworten generiert.

Ethische Leitplanken

Diese Leitplanken sorgen dafür, dass Ihr Projekt mit menschlichen Werten in Einklang steht. Dazu gehört das Überprüfen auf Toxizität und Verzerrung.

Von Toxizität spricht man, wenn ein AI-Modell hasserfüllte, beleidigende und ordinäre oder obszöne Inhalte generiert. Verzerrungen liegen vor, wenn AI schädliche Stereotypen widerspiegelt, wie z. B. Stereotypen in Bezug auf die ethnische Herkunft oder das Geschlecht. Wie Sie sich vorstellen können, ist das katastrophal! Da AI ihre Antworten erlernt, können Toxizität und Verzerrung ein Zeichen dafür sein, dass Ihre Daten unerwünschte Sprache und Ideen in Ihr Modell eintragen. Die Toxizitätserkennung identifiziert Antworten, die möglicherweise toxische Sprache enthalten, sodass Sie sie manuell überprüfen und Anpassungen vornehmen können, um die Toxizität zu verringern.

Sie wissen jetzt, was Leitplanken sind und wie sie Ihr Projekt vor Risiken schützen. Als Nächstes sehen wir uns an, wie Becca Leitplanken in ihrer Vertrauensstrategie implementiert.

Die Vertrauensstrategie von Coral Cloud

Die Umsetzung Ihrer Vertrauensstrategie sieht unterschiedlich aus, je nachdem, welches System Sie verwenden. Da Becca Salesforce einsetzt, basiert ihre Vertrauensstrategie auf der Einstein-Vertrauensebene. Die Vertrauensebene ist eine Sammlung von Funktionen, Prozessen und Richtlinien mit dem Zweck, den Datenschutz sicherzustellen, die AI-Genauigkeit zu verbessern und die verantwortungsvolle Nutzung von AI im gesamten Salesforce-Ökosystem zu fördern. Wenn Sie ein Projekt mit Funktionen von Einstein Generative AI erstellen, wie etwa in Beccas Projekt dem Prompt Builder (Aufforderungsgenerator), durchläuft es automatisch die Vertrauensebene.

Becca verwendet Funktionen der Vertrauensebene, um eine Vertrauensstrategie zu definieren, die alle Risikobereiche abdeckt. Außerdem visualisiert sie das gewünschte Ergebnis. Hier ist ein Auszug aus ihrer Vertrauensstrategie.

Risikobereich |

Beccas Vertrauensstrategie |

Funktionen in der Vertrauensebene |

Ergebnis |

|---|---|---|---|

Datenlecks |

|

|

|

Rufschädigung |

|

|

|

Bevor Becca ihre Vertrauensstrategie finalisiert, bespricht sie sich mit ihrem Rechts- und Sicherheitsteam, um sicherzustellen, dass es keine Lücken gibt.

Nächste Schritte

Da nun auch die Vertrauensstrategie fertig ist, hat Becca die Planung ihres Projekts abgeschlossen. Sie ist nun bereit, die Phase "Erstellen" einzuleiten, in der sie ihr Projekt in Salesforce implementieren wird. Verfolgen Sie Beccas Projekt in Verbinden von Data 360 mit Agentforce und Prompt Builder (Aufforderungsgenerator) weiter.

Denken Sie bei der Erstellung Ihres Projekts daran, dass die Risikominderung keine Aufgabe ist, die man einmal erledigt und dann abhakt. Wenn Sie Ihr Projekt implementiert haben, sollten Sie Ihr Risiko laufend überwachen und prüfen. Die Überwachung hilft Ihnen, problematische Trends frühzeitig zu erkennen und Anpassungen vorzunehmen. Prüfen Sie die Toxizitätswerte und das Feedback, um festzustellen, wo Ihre Lösung Mängel hat, und nehmen Sie Anpassungen vor, um Risikofaktoren zu beseitigen.

Zusammenfassung

In diesem Modul werden die wichtigsten Schritte bei der Vorbereitung Ihres AI-Projekts erläutert. Sie wissen nun, wie Sie Projektbeteiligte identifizieren, Ziele festlegen und eine technische Lösung wählen. Sie wissen, wie Sie Daten hoher Qualität vorbereiten und die Anforderungen Ihres Projekts erfüllen. Und Sie wissen, wie eine Vertrauensstrategie die Risiken für Ihr Projekt mindert und warum es wichtig ist, Risiken zu überwachen.

Mit all diesem neuem Wissen sind Sie bestens gerüstet, um ein erfolgreiches AI-Projekt zu beginnen! Bevor Sie mit der Einführung beginnen, sollten Sie unbedingt das Modul Änderungsmanagement für die AI-Implementierung absolvieren.

Ressourcen

- PDF: Das Artificial Intelligence Risk Management Framework (AI RMF) von NIST (in englischer Sprache)

- Excel-Tabelle: Vorlage zur AI-Risikobewertung von NIST (in englischer Sprache)

- PDF: Aufbau von Vertrauen in AI unter menschlicher Kontrolle (in englischer Sprache)

- Trailhead: Änderungsmanagement für die AI-Implementierung

- Trailhead: Die Einstein-Vertrauensebene

- Artikel: AI-gestützte Cyberangriffe (in englischer Sprache)

- Artikel: Verstehen, warum AI-Leitplanken notwendig sind: Sicherstellen einer ethischen und verantwortungsvollen AI-Nutzung (in englischer Sprache)

- PDF: Mindern von LLM-Risiken über die Gen AI-Grenzen von Salesforce hinaus (in englischer Sprache)